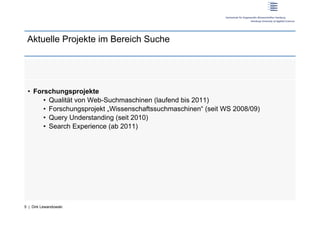

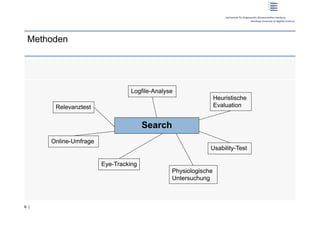

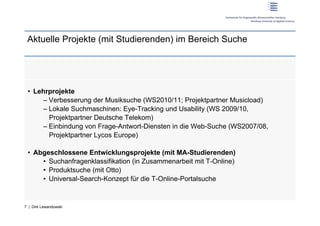

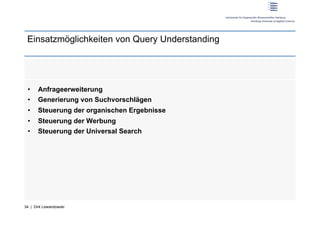

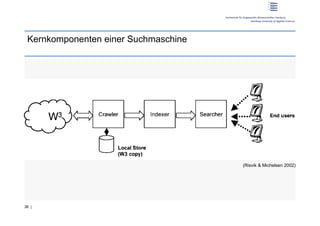

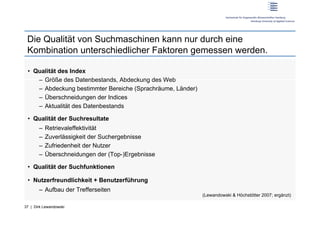

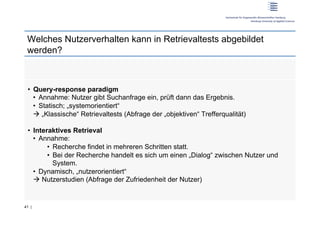

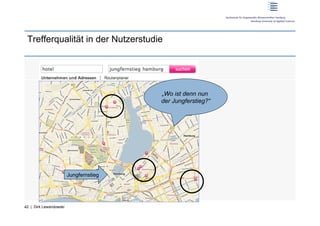

Prof. Dr. Dirk Lewandowski von der Hochschule für angewandte Wissenschaften Hamburg untersucht die Qualität von Suchmaschinen und das Nutzerverhalten, um Empfehlungen zur Verbesserung von Suchsystemen abzuleiten. Aktuelle Forschungsprojekte befassen sich mit der Analyse von Suchanfragen, Query Understanding und der Nutzererfahrung, während die Qualität von Suchmaschinen aus verschiedenen Faktoren wie Indexqualität und Nutzerfreundlichkeit gemessen wird. Das Fazit betont die Notwendigkeit von Kooperationen zwischen Forschung und Industrie, um ein besseres Gesamtverständnis des Suchprozesses zu entwickeln.