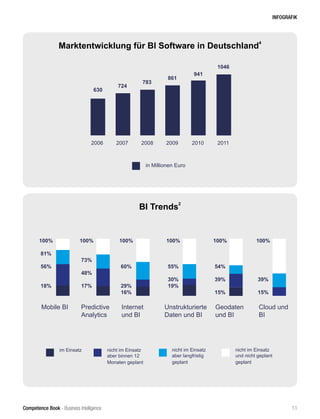

Das Dokument diskutiert die aktuellen Herausforderungen und Chancen in der Business Intelligence (BI) durch Consumerization, Agilität und Big Data, die bestehende BI-Strategien in Frage stellen. Es hebt die Notwendigkeit hervor, neue Datenanalysestrategien zu entwickeln und betont die steigende Bedeutung von Daten als strategisches Wirtschaftsgut für den Unternehmenserfolg. Der BARC BI Congress bietet Unternehmen Orientierung und Best Practices, um in der dynamischen BI-Landschaft innovativ zu bleiben.

![Competence Book - Business Intelligence

ANWENDUNGEN - PERFORMANCE MANAGEMENT

80

Einführung der Balanced Scorecard

Die BSC ist ein von Robert S. Kaplan zu

Beginn der 1990er-Jahre entwickeltes Füh-

rungsinstrument zur strategischen Ausrich-

tung der Unternehmensorganisation an-

hand von Ursache-Wirkungs-Beziehungen.

Hierfürwerden strategische Ziele in den vier

verschiedenen Perspektiven Finanz, Kunde,

Prozess und Potenzial messbar gemacht.

Das ermöglicht es, geeignete Maßnahmen

zu identifizieren.

Im Vergleich zu produzierenden Industri-

eunternehmen ist es für Dienstleistungs-

unternehmen schwieriger, bereichsspe-

zifische Kennzahlen zum Beispiel für die

Produktivität oder Innovationsfähigkeit

anzugeben. Einzig bei finanziellen Kenn-

zahlen ergeben sich Parallelen. Somit sind

es auf Bereichsebene andere Kernkriterien

als jene, die für den Unternehmenserfolg

eines Dienstleistungsunternehmens als

Ganzes entscheidend sind. Dazu zählen

etwa Mitarbeitermotivation, Kundenzu-

friedenheit oder Kundenbeziehungen. Die

Balanced Scorecard hilft hier als Modell,

da sie auch nicht finanzielle Kennzahlen

zur Erfolgsmessung berücksichtigt. Mit der

Einführung der BI sollte nun die BSC als

Modell zur Erstellung von Kernkennzahlen

aufgegriffen und in der CSV-Abteilung im-

plementiert werden. Das BI-System sollte

neben den klassischen finanziellen Kenn-

zahlen auch nicht finanzielle Kennzahlen

abbilden können.

Obwohl im Falle der CSV bereits definierte

Unternehmenskennzahlen vorhanden wa-

ren, rät Probst [Pro07, S. 198] davon ab, diese

bei der Umsetzung der Balanced Scorecard

als Grundlage zu nehmen: „Es kann doch

eigentlich so einfach sein. Man hat ein aus-

geprägtes Kennzahlensystem, gießt dieses

in ein paar Perspektiven und fertig ist die

Balanced Scorecard. Nein! Erst die Strate-

gie, dann Ziele, dann erst Kennzahlen. Und

ob es dann noch die vorhandenen sind, ist

überhaupt die Frage.“

In der Literatur wie auch in der Praxis ist

man sich einig, wie eine Balanced Scorecard

erfolgversprechend umgesetztwerden sollte

[Pro07, S. 198]. Die Vorgehensweise umfasst

das Herunterbrechen von Vision und Stra-

tegie in konkretes Handeln, und zwar zum Handeln im operativen Umfeld und nicht

nur auf höchster Managementebene. Für dieses Projekt wurde eine von Probst vor-

geschlagene Einführungsmethode [Pro07, S. 176] als Grundlage verwendet und den

Anforderungen entsprechend modifiziert. Dies wird im folgenden Abschnitt genauer

beschrieben.

Einführungsmethodologie

In der Literatur [GGD08] sind einige Vorgehensmodelle für die Einführung von Bu-

siness Intelligence zu finden. Diese Vorgehensmodelle gehen jedoch oft davon aus,

dass die zu messenden Kennzahlen bereits bekannt sind und nicht erst komplett neu

definiert werden müssen. Diese Methoden konzentrieren sich nur auf die Ermittlung

von Kennzahlen, jedoch nicht auf deren Einführung – insbesondere nicht auf Basis

der Balanced Scorecard. Eine Fragestellung des Projekts lautete daher zusätzlich, wie

man erfolgreich Kennzahlen im Rahmen der Balanced Scorecard und der Business

Intelligence in einem Beratungs- beziehungsweise Dienstleistungsunternehmen für

eine Abteilung definiert.

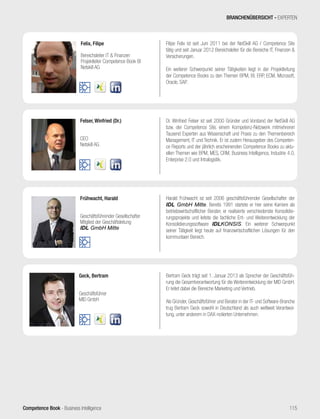

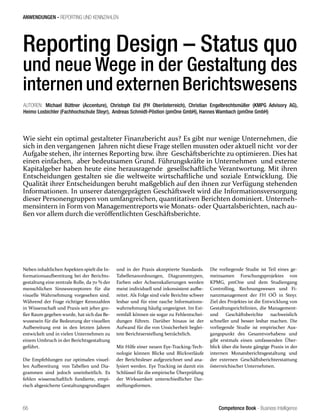

Für die Entwicklung eines Vorgehensmodells, das beide Aspekte abdeckt, sowohl die

BSC wie auch die BI, müssen zwei erfolgreiche Methoden kombiniert werden – im

Falle dieses Projekts wurde die BI-Methodik um die BSC-Methodik ergänzt. Zur Im-

plementierung der BI-Lösung entschied sich das Unternehmen für die Lifecycle-Me-

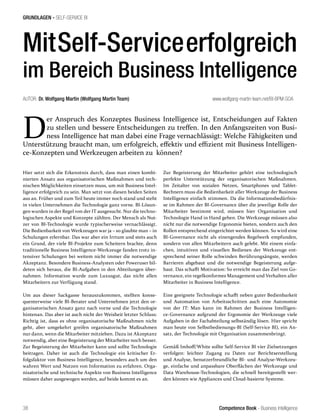

thode nach Kimball. Abbildung 1 stellt Kimballs Vorgehensweise grafisch dar. Die Ent-

wicklung und Umsetzung gliederte sich in verschiedene Phasen:

Anforderungsaufnahme

Die Anforderungsaufnahme beinhaltete die Analyse der Ist- und der Soll-Situation für

BI, die Kennzahlenermittlung im Rahmen der Balanced Scorecard sowie die Definiti-

on der Datendimensionen. Für die Analyse der Ist- und Soll-Situation und zur Bestim-

mung der Datendimensionen wurde die Vorgehensweise von Kimball zugrunde gelegt.

Dabei wurden Interviews in Workshops durchgeführt und die Technik „Enterprise Da-

ta Warehouse Bus Matrix“ [Kim08, S. 3ff] angewendet. Die Kennzahlenermittlung im

Rahmen der Balanced Scorecard erfolgte mit der modifizierten Methode von Probst

[Pro07, S. 180]:

1. Analyseder Ist-Kennzahlen: Als Startpunktdienteeine Übersicht überalle Kenn-

zahlen, sowohl die des Unternehmens wie auch die der Abteilung, welche innerhalb

der CSV-Abteilung gemessen wurden.

Program/

Project

Planning

Business

Requirements

Definition

Technical

Architecture

Design

Product

Selection &

Installation

Dimensional

Modeling

Physical

Design

ETL

Design &

Development

BI

Application

Design

BI

Application

Development

Deployment

Growth

Maintenance

Program/Project Management

Abb. 1: Lifecycle-Methode von Kimball, Quelle: [Kim08] S. 3](https://image.slidesharecdn.com/competencebookbusinessintelligence-140324092547-phpapp02/85/Business-Intelligence-BI-Kompakt-80-320.jpg)

![Competence Book - Business Intelligence

ANWENDUNGEN - PERFORMANCE MANAGEMENT

81

2. Identifizierung strategischer Ziele: Im zweiten Schritt

analysiertendieVerantwortlichendieVision, die Strategie

und die kritischen Erfolgsfaktoren des Unternehmens.

3. Soll-Ist-Vergleich: Zum besseren Überblick setzten sie

die Unternehmens- und CSV-Kennzahlen in ein strate-

gisches Zielgerüst ein und wiesen sie den Perspektiven

der BSC zu. Hier verglichen sie, inwiefern die aktuellen

CSV-Kennzahlen die Kennzahlen, die aus der Unterneh-

mensstrategie hervorgehen, abdecken.

4. Identifizierung fehlender Kennzahlen: Die Mana-

ger und Experten diskutierten, ob wichtige Kennzahlen

fehlen.

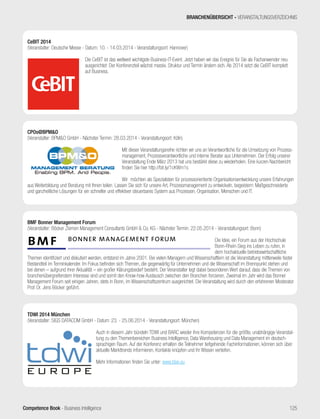

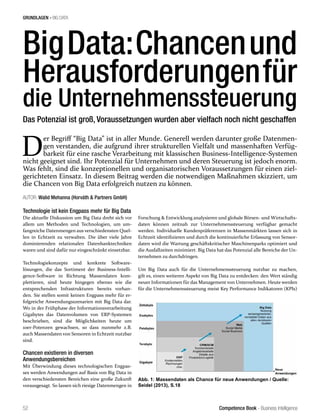

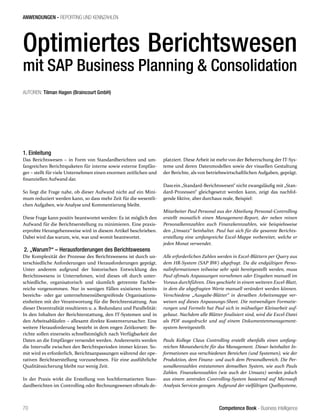

5. Eingrenzung und Modellierung von Ursache-Wir-

kungs-Ketten: Der nächste Schritt bestand darin, die

wichtigsten Kennzahlen einzugrenzen. Aufgrund einer

Vorgabe der CSV-Leitung sollten für jede Perspektive

zwei Kennzahlen ausgewählt werden. Dafür analysier-

ten die Verantwortlichen die Ursache-Wirkungs-Bezie-

hungen der ausgewählten Kennzahlen. Dazu verwende-

ten sie die Technik des Papiercomputers, ein von Vester

[Hae98] entwickeltes Verfahren, bei dem alle Faktoren in

einer Einflussmatrix abgebildet und auf gegenseitige Be-

einflussung und Beeinflussbarkeit überprüft werden.

6. Bestimmung der CSV- Kennzahlen: Die Manager be-

werteten einzelne Faktoren und setzten sie innerhalb

einer Matrix zueinander in Bezug. Die jeweils zwei wich-

tigsten und kritischsten Kennzahlen pro Perspektive

wurden ausgewählt. Abbildung 2 zeigt das Ergebnis der

Kennzahlenbewertung innerhalb der Einflussmatrix.

7. Bestimmung von Messzahlen und Zielgrößen zur

Messung der Zielerreichung: Mittels Workshops wur-

den für die neuen CSV-Kennzahlen die Messarten (wie

wird gemessen) und die Zielgrößen bestimmt. Die Mess

art und die Zielwerte wurden zumeist aus der Strategie

vorgegeben.

Die Ergebnisse dieser Ermittlung sind in Tabelle 1 dargestellt. Die-

ses Vorgehen zur Kennzahlenermittlung im Rahmen der Balanced

Scorecard zeigte sich in der Praxis als sehr effektiv und erfolgreich.

Architektur und Auswahl der BI-Tools

Für den Entwurf der BI-Architektur und die Auswahl der BI-Produkte

empfiehlt Kimball folgendes Vorgehen [Kim08, S. 181]:

1. Architekturdesign:

–

Aufnahme der architektonischen Anforderungen und

Datenquellenanalyse

– Entwurf eines Architekturmodells

– Ableiten der architektonischen Auswirkungen

–

Erstellen eines Anforderungskatalogs für die BI-Teil

systeme

2. Auswahl und Installation der BI-Produkte:

– Produktauswahl mittels einer Nutzwertanalyse

– Installation der BI-Produkte

Die Experten benutzten bei der Erstellung einer Architektur das

High-Level-Architektur-Modell von Kimball. Dieses wurde einerseits

gewählt, um das Modell so grob wie möglich zu halten und sich nicht

in zu detaillierten Informationen zu verlieren. Andererseits deckt

Kimballs Modell alle notwendigen Funktionen und Datenbereiche ab

und erwies sich in der Praxis anhand einer Expertenbefragung als sehr

erfolgreich.

Kurz vor der Entwicklung des BI-Systems wurde eine unternehmen-

sweite Sharepoint-Umgebung eingerichtet. Aufgrund dessen war ur-

sprünglich beabsichtigt, Microsoft Sharepoint Online als BI-Frontend

einzusetzen. Bei Untersuchungen im Vorfeld wurde jedoch festge-

stellt, dass im Gegensatz zu SharePoint 2010 die Cloud-Version von

SharePoint (das ist auch heute noch der Fall) keine Unterstützung für

BI anbot [Mic11]. Das Management entschied daher, als Interimslö-

sung Microsoft Excel 2010 als vorläufiges BI-Frontend einzusetzen.

Um sicherzustellen, dass dieser Weg gangbar ist, wurden die ge-

sammelten Anforderungen mit den Funktionen von Excel verglichen.

Es stellte sich heraus, dass Microsoft Excel 2010 alle Anforderungen

erfüllte und als Frontend eingesetzt werden konnte. Sollte der Fall ein-

treten, dass viele und komplexe Daten analysiert werden müssen, ist

eine Erweiterung mit Microsoft PowerPivot sehr leicht umsetzbar.

Akquirierter

Umsatz

Key

Accountant

Management

Umsatz

Anzahl Skills

Kunden-

anfragen

Kunden-

zufriedenheit

Anzahl

Rahmen-

verträge

Mitarbeiter-

zufriedenheit

Headcount /

Mitarbeiter-

fluktuation

Durchschn.

Stundensatz

Rentabilität

Anzahl

interner

Projekte

Academy /

Weiterbildung

Auslastung

kritisch

passiv

aktiv

träge

hoch

hoch

niedrig

niedrig

Kumulierte Einflussstärke

Kumulierte

Beeinflussbarkeit

Abb. 2: Ergebnis der Kennzahlenbewertung mittels

Einflussmatrix

Kennzahl Definition Perspektive

Rentabilität Höhe der Rentabilität für den Bereich CSV in Prozent Finanzen

Akquirierter Umsatz Anzahl akquirierter Umsatz durch CSV-Mitarbeiter Finanzen

Headcount Anzahl der CSV-Mitarbeiter (Count) bzw. Mitarbeiterfluk-

tuation

Prozesse/Produkt

Skills Anzahl der Skills der CSV-Mitarbeiter

(Fähigkeiten/

Qualifikationen)

Prozesse/Produkt

Mitarbeiter

zufriedenheit

Mittelwert gemäß Umfrage Mitarbeiter

Academy Prozentzahl der entwickelten Skills gemäß Vereinbarung in

Mitarbeitergespräch

Mitarbeiter

Kundenzufriedenheit Mittelwert gemäß Umfrage Kunde

Auslastung Prozentzahl der Auslastung der CSV-Mitarbeiter Kunde

Tab. 1: Resultat der Kennzahlenermittlung](https://image.slidesharecdn.com/competencebookbusinessintelligence-140324092547-phpapp02/85/Business-Intelligence-BI-Kompakt-81-320.jpg)

![Competence Book - Business Intelligence

ANWENDUNGEN - PERFORMANCE MANAGEMENT

82

Zur Auswahl des Backend verglichen die Verantwortlichen ver-

schiedene Datenbankmanagementsysteme und evaluierten sie

mittels Nutzwertanalyse. Die Entscheidung fiel auf MS SQL

Server 2012. Eine detaillierte Analyse klärte ab, welche Edition

eingesetzt werden sollte. Die Editionen dieser Datenbankplatt-

form unterscheiden sich signifikant hinsichtlich BI-Funktionali-

tät und Lizenzkosten. Aufgrund des begrenzten Projektbudgets

kamen nur die Standard-, Web- und Express-Editionen in Frage.

Bei der Analyse stellte man fest, dass nurdie Standard-Edition die

sogenannten Analysis-Services unterstützt, die für das Erstellen

von Cubes unabdingbar sind. Somit fiel die Entscheidung auf die

Standard-Edition.

Data Warehouse, ETL und Cubes

Im nächsten Schritt wurden das Data Warehouse, die ETL-Pro-

zesse und die Cubes entwickelt. Dieser Teil des Projekts nahm

mit 40 Prozent anteilsmäßig die meiste Zeit in Anspruch. Da eine

Konstruktion plattform-, projekt-, software- und hardwareab-

hängig ist und diese Faktoren sich auch schnell verändern, gibt

Kimball in diesem Teil eher eine grobe Anleitung vor [Kim08,

S. 327].

Das Management teilte für dieses Projekt das Data Warehouse

klassisch in drei Bereiche auf: Stage, Store und Mart. Danach

wurden die verschiedenen Datenquellen detaillierter analysiert.

Damit die gewünschten Daten aus den Datenquellen im Data

Warehouse vereinigt werden konnten, entwickelten die Verant-

wortlichen verschiedene ETL-Prozesse mittels der sogenannten

SQL Server Integration Services (SSIS). Nachdem die gewünsch-

ten Daten erfolgreich in den Mart geladen wurden, war der letzte

Schritt dieser Phase die Erstellung der Cubes. Zuerst wählten sie

die Faktentabellen aus, danach die Messzahlen. Zum Schluss wa-

ren die gewünschten Dimensionen an der Reihe. Kimball schlägt

vor, stets mit der Zeitdimension zu beginnen, um rasch erste

Ergebnisse zu erhalten [Kim08, S. 305]. Insgesamt wurden drei

Cubes erstellt mit jeweils bis zu fünf Dimensionen.

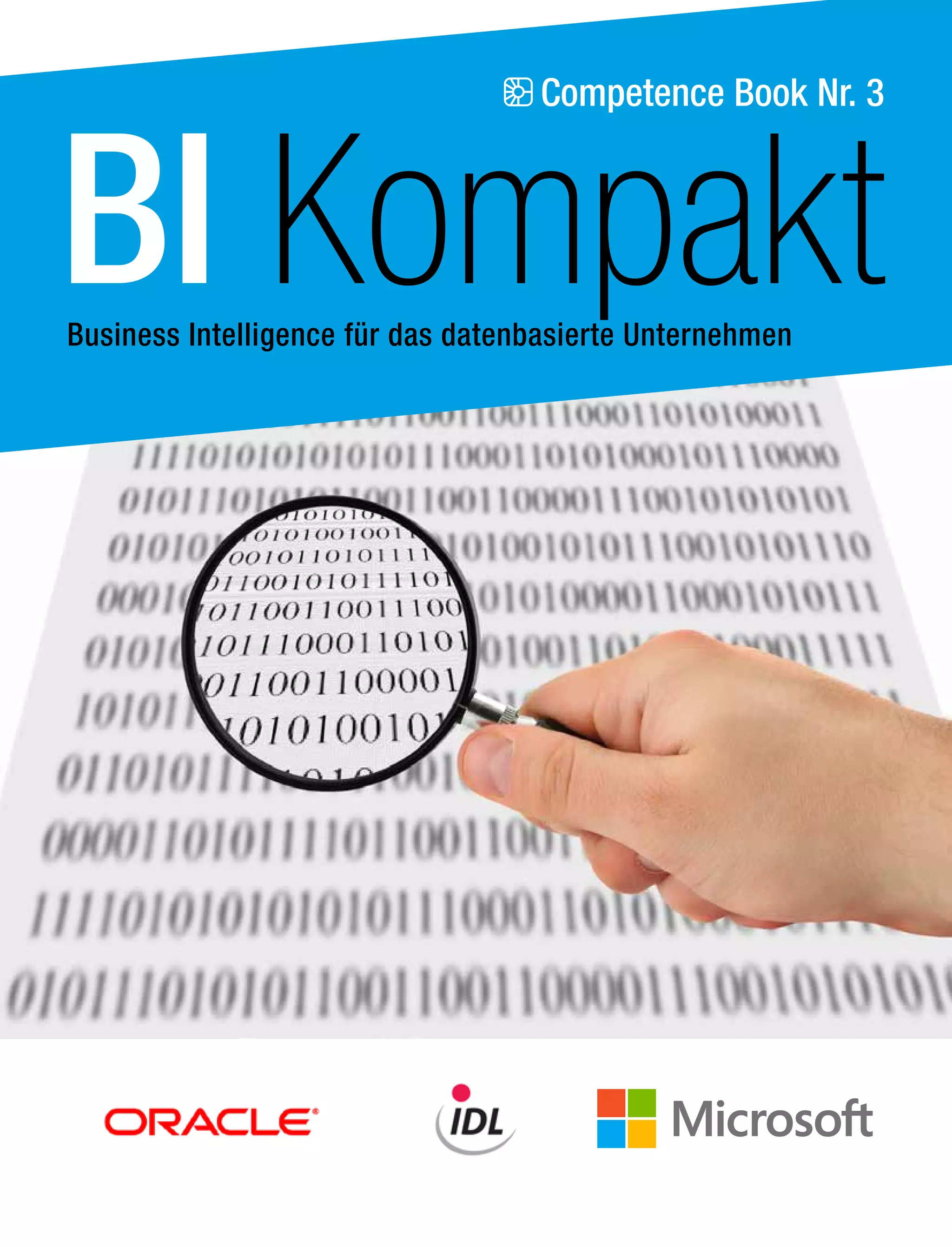

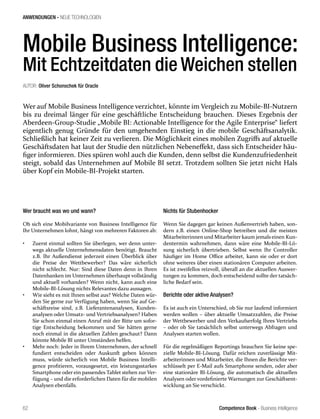

Entwurf und Entwicklung des Business Intelligence

Frontend

Nach der erfolgreichen Erstellung des Backend entwarfen die

Experten das Frontend. Das Frontend spielt eine zentrale Rol-

le für die Akzeptanz des gesamten BI-Systems. Usability und

Performance stehen hier im Mittelpunkt. Microsoft Excel 2010

unterstützt eine Anbindung an die SQL Server Analysis Ser-

vices (SSAS) und eine detaillierte Auswertung kann über die Pi-

vot-Funktion durchgeführt werden. Zudem wurde Excel bereits

innerhalb des Unternehmens eingesetzt, was ein Vorteil für die

Akzeptanz als Frontend war. Eine der Anforderungen an das BI-

System lautete, ein Cockpit, also eine Übersicht über die Kenn-

zahlen zu erstellen, damit die CSV-Abteilungsleitung auf einen

Blick den momentanen Stand der Abteilung übersehen kann.

Das Cockpit beinhaltet alle vorgegebenen Kennzahlen, angeord-

net nach der Balanced Scorecard. Die Kennzahlen, die sich täg-

lich automatisch aktualisieren, werden in die Excel-Datei geladen

und die Ist-Werte in das Cockpit importiert. Zur besseren Iden-

tifikation des momentanen Status wurden Ampeln eingesetzt

(siehe Abbildung 3).

Des Weiteren erstellten die Verantwortlichen für jede Kennzahl

eine eigene Tabelle. Somit kann die CSV-Abteilungsleitung auf

Wunsch mittels Pivot-Funktion jede Kennzahl analysieren. Mit

diesen sehr performanten und individuellen Analysen (zum Bei-

spiel Drill-down) kommt hier ganz deutlich die Stärke von Bu-

siness Intelligence zur Geltung.

Implementierung, Wartung und Wachstum

In der Implementierungsphase präsentierten die Verantwort-

lichen Backend und Frontend den Projektsponsoren und dem

Lenkungsausschuss, der dem Projekt dann zustimmte. Zur Im-

Abb. 3: BI-Frontend (Cockpit)](https://image.slidesharecdn.com/competencebookbusinessintelligence-140324092547-phpapp02/85/Business-Intelligence-BI-Kompakt-82-320.jpg)

![Competence Book - Business Intelligence

ANWENDUNGEN - PERFORMANCE MANAGEMENT

83

plementierung gehörten das Bereitstellen der notwendigen Zu-

gangsberechtigungen für die BI-Anwender, die Systemimple-

mentierung, Dokumentationen und Trainings. Sowohl Backend

als auch Frontend benötigen Wartungsaktivitäten, die geplant

werden müssen. Dabei definierten die Experten im Rahmen des

Projekts neue BI-Prozesse, um die Kommunikation mit BI-An-

wendern und die Weiterentwicklung des BI-Systems zu gewähr-

leisten. Als Verantwortlicher wurde eine neue, interne Rolle ent-

wickelt, der „Business Intelligence Specialist“ (BIS). Der BIS dient

innerhalb von CSV als Anlaufstelle für alle Fragen rund um das

BI.

Ergebnis und Ausblick

Als Ergebnis des Projekts liegen der Arcondis AG nun Kenn-

zahlen und ein BI-System für die CSV-Abteilung vor, die alle

vorgegebenen Anforderungen erfüllen. Das System wird von der

Abteilungsleitung CSV bereits produktiv verwendet, und ein

neues Projektbudget für die Weiterentwicklung der BI wurde vor

kurzem von der Geschäftsleitung bewilligt.

Mittelfristig soll das BI-System nicht nur abteilungs-, sondern

unternehmensweit eingesetzt werden. Das Backend wurde kon-

zeptionell bewusst als Enterprise Data Warehouse mit mehreren

Layern aufgebaut (Stage, Store und Mart), sodass das Erstellen

neuer Data Marts in Zukunft keine komplexe Aufgabe darstellt.

Das Projekt zeigt, dass auch kleinere Unternehmen mit sehr be-

grenzten IT-Ressourcen eine leistungsfähige und zukunftssichere

BI-Infrastruktur aufbauen und betreiben können. Das Wichtigste

ist, das BI-System kontinuierlich weiterzuentwickeln, denn Ralph

Kimball sagt unmissverständlich: „A BI system is never really

finished.“

Projekt: Einführung einer Balanced Scorecard

Dauer 3 Monate

Aufwand

Ressourcen

Student (300 Std.)

Betreuer (40 Std.)

Business (20 Std.)

IT (12 Std.)

Eingesetzte Tools Microsoft Excel 2010 (Frontend)

Microsoft SQL Server 2012 Standard (Backend)

Anwender 2 Anwender (aktuell)

12 Anwender (geplant)

Tab. 2: Projektdaten

[Pro07] Probst, H.-J.: Balanced Scorecard leicht gemacht: Ziel-

größen entwickeln und Strategien erfolgreich umsetzen. 2. Aufl.,

Heidelberg 2007

[GGD08] Gluchowski, P. / Gabriel, R. / Dittmar, C.: Mana

ge

-

ment Support Systeme und Business Intelligence – Computerge-

stützte Informationssysteme für Fach- und Führungskräfte. 2.

Aufl., Springer 2008

[Kim08] Kimball, R. et al.: The Data Warehouse Lifecycle Tool-

kit. 2. Aufl., Indianapolis: Wiley 2008

[Hae98] Haedrich, G. et al. (Hrsg.): Tourismus-Management, 3.

Aufl., de Gruyter 1998, S. 486

[Mic11] Microsoft Office 365, 2011 [Internet]. http://community.

office365.com/en-us/f/154/p/8112/33521.aspx” l “33521”, http://

community.office365.com/en-us/f/154/p/8112/33521.aspx#33521,

abgerufen am 17.5.2012

Quelle: BI-SPEKTRUM Ausgabe 3 / 2013

BI-SPEKTRUM wendet sich an alle für Business Intel-

ligence (BI) und Data Warehousing (DW) in Unterneh-

men Verantwortlichen, Softwarehäuser und Berater,

die solche Systeme entwickeln und implementieren,

genauso wie Wissenschaftler, die in dieser Disziplin

forschen und entwickeln und damit die Basis für neue

Praxisanwendungen liefern. Es informiert seine Leser

über alle Trends in diesem Bereich, liefert Anwen-

dungsfälle aus der Praxis (Case Studies) und präsen-

tiert Meinungen zu aktuellen Themen, sowie Neuigkei-

ten für die BI-Community.

Weitere Informationen unter: www.bi-spektrum.eu](https://image.slidesharecdn.com/competencebookbusinessintelligence-140324092547-phpapp02/85/Business-Intelligence-BI-Kompakt-83-320.jpg)