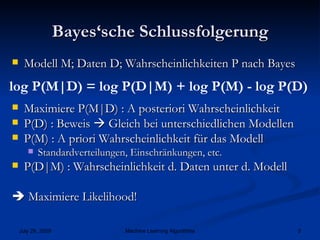

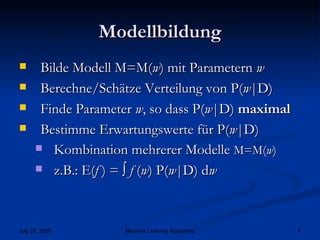

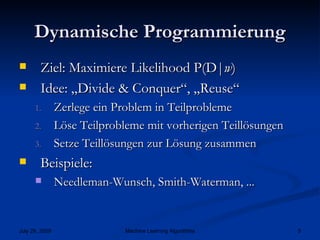

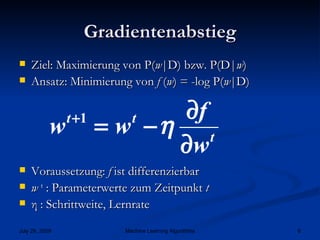

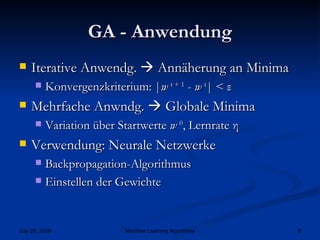

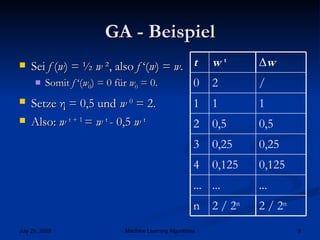

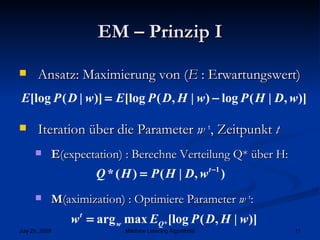

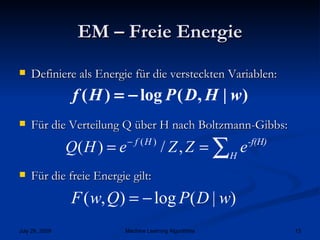

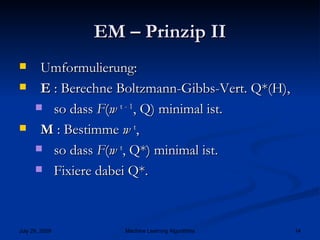

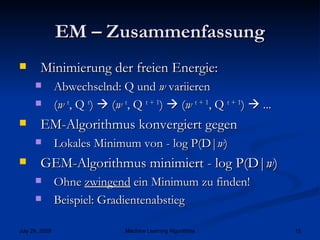

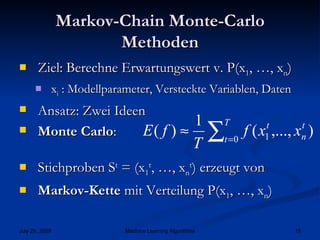

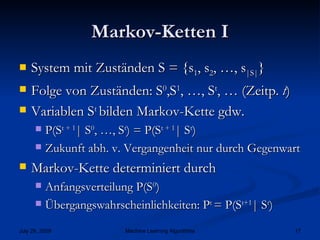

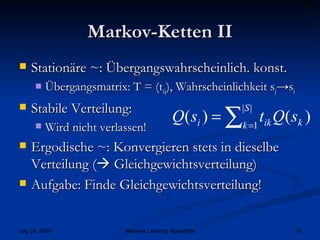

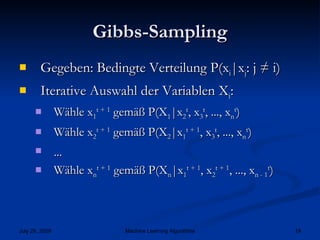

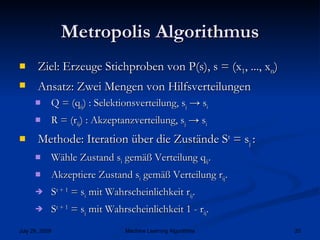

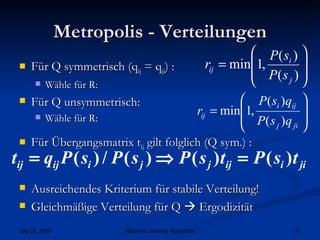

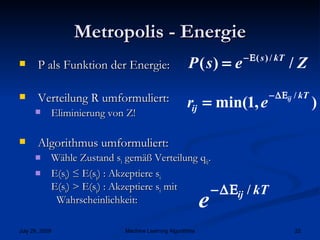

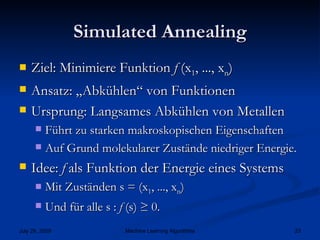

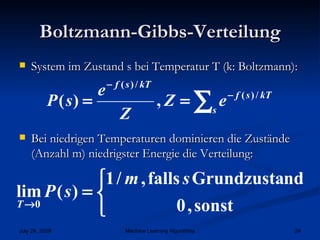

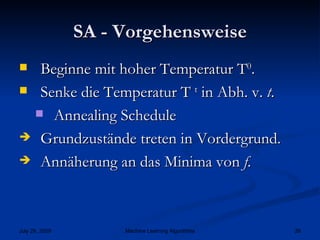

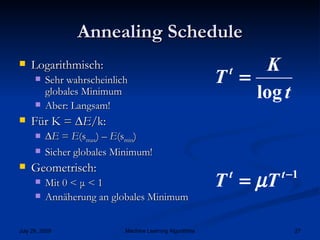

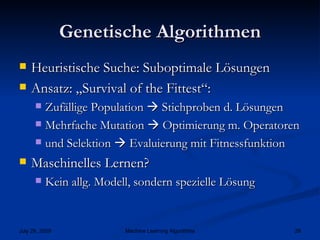

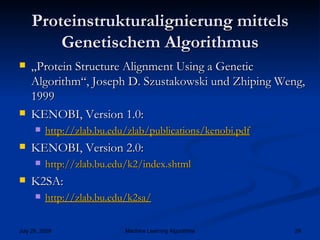

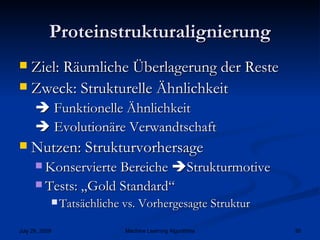

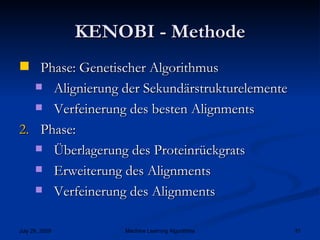

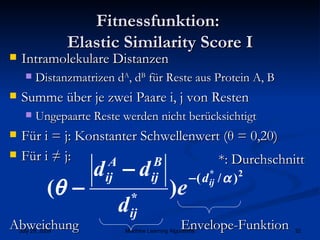

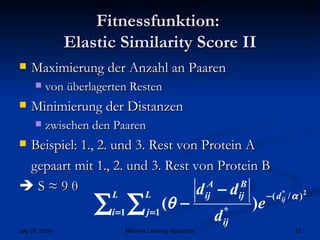

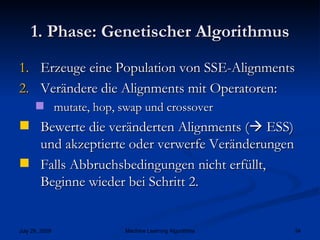

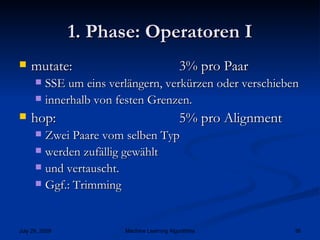

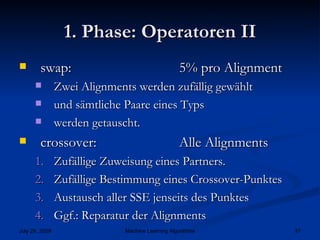

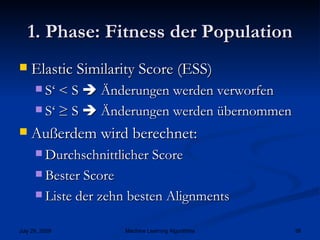

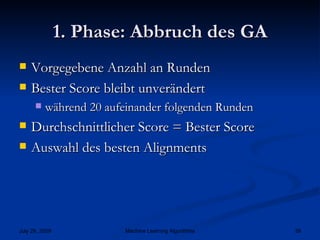

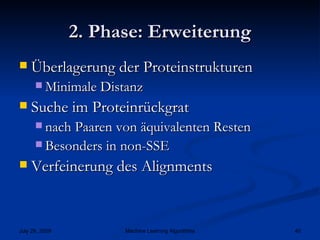

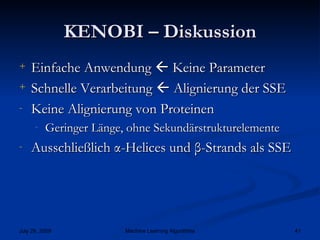

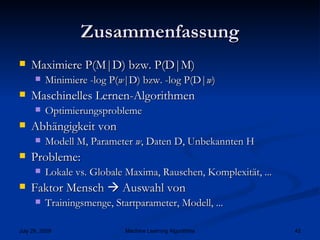

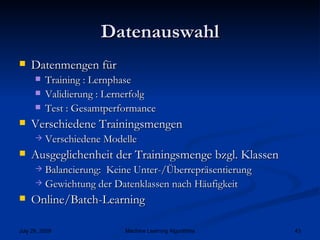

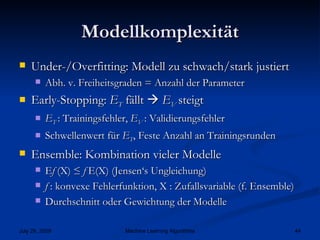

Das Dokument behandelt verschiedene Algorithmen des maschinellen Lernens, einschließlich Gradient Abstieg, Monte Carlo Methoden und genetische Algorithmen. Es erläutert Konzepte wie die Bayessche Schlussfolgerung, dynamische Programmierung und die Optimierung von Modellen zur Maximierung der Wahrscheinlichkeit von Daten. Wichtige Anwendungen, wie die Proteinstrukturalignierung, werden präsentiert, zusammen mit Techniken zur Vergleichsanalyse von Algorithmen.