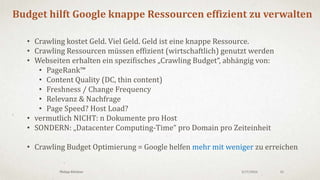

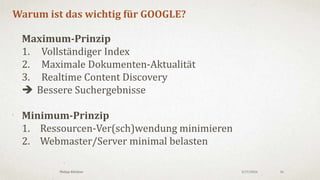

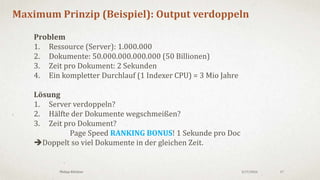

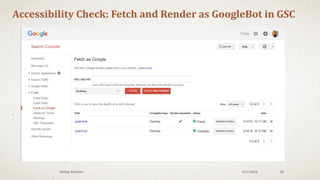

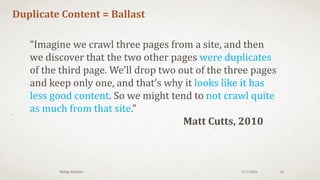

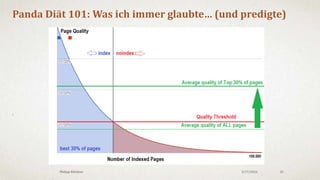

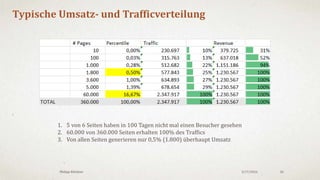

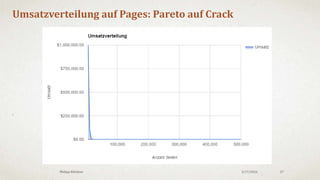

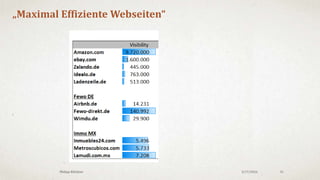

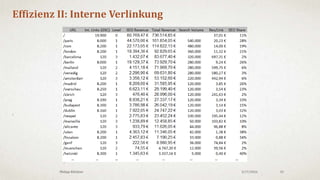

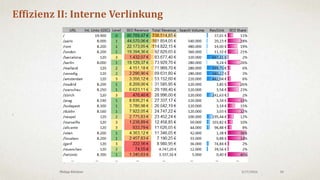

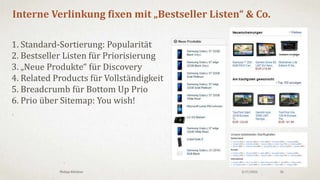

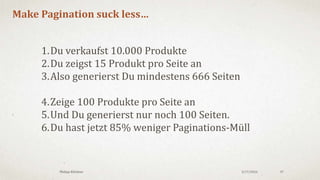

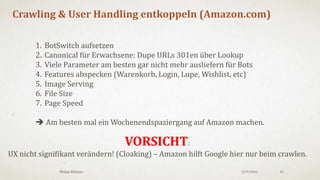

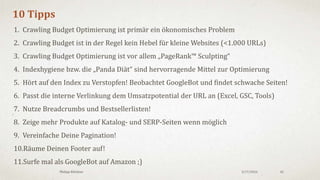

Das Dokument behandelt die ökonomischen Aspekte des Crawling und das Crawling-Budget von Google, welches eine knappe Ressource ist, die effizient genutzt werden muss. Webmaster stehen vor Herausforderungen wie Vollständigkeit, Aktualität und Content-Entdeckung, um ihre Crawling-Strukturen zu optimieren. Die Präsentation schlägt Strategien vor, um unnötige Inhalte zu vermeiden und die Effizienz durch interne Verlinkung und Priorisierung wichtiger Seiten zu steigern.