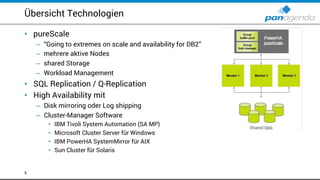

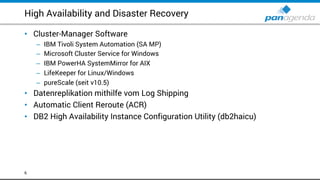

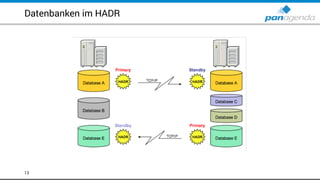

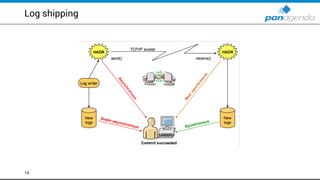

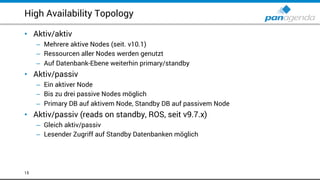

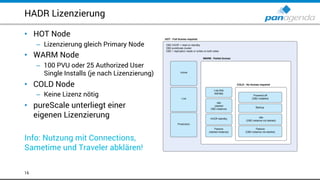

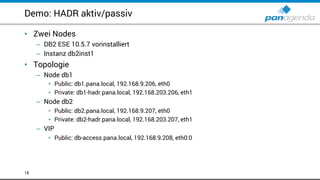

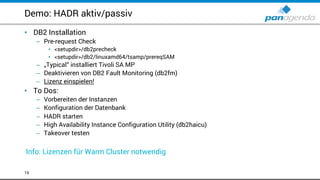

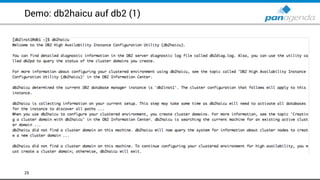

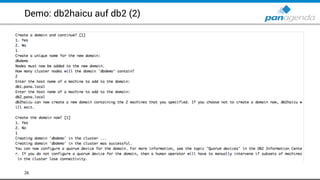

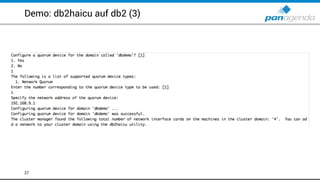

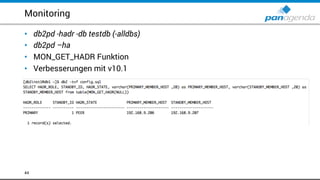

Das Dokument bietet eine umfassende Übersicht über hohe Verfügbarkeit (High Availability) und Notfallwiederherstellung (Disaster Recovery) für DB2 in Verbindung mit IBM Connections, Sametime und Traveler. Es werden verschiedene Cluster-Technologien, Implementierungsansätze sowie praktische Beispiele für die Konfiguration und den Betrieb bereitgestellt. Darüber hinaus werden Tipps zur Administration und zum Monitoring gegeben, um eine zuverlässige Datenverfügbarkeit zu gewährleisten.