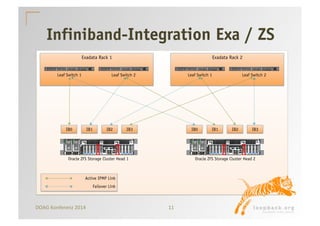

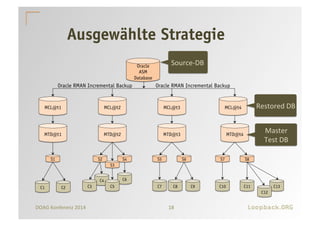

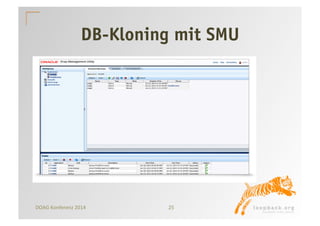

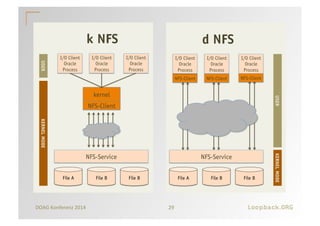

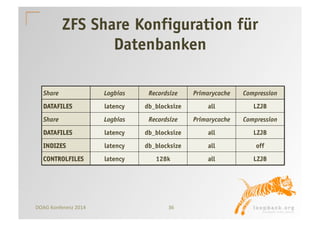

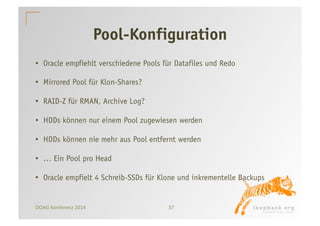

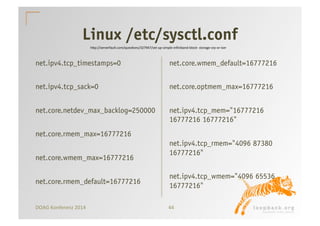

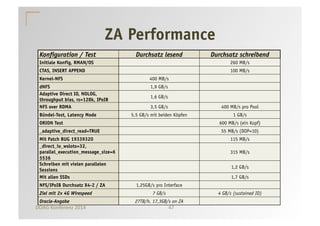

Der Erfahrungsbericht beschreibt den Klonprozess von Exadata-Datenbanken unter Verwendung der Oracle ZFS Appliance, die eine effiziente Speicherung und Bereitstellung von Daten durch schnelle Durchsatzraten, Snapshots und Klon-Funktionalitäten ermöglicht. Es werden Herausforderungen wie Platzverbrauch, lange Laufzeiten und Netzwerkverkehr hervorgehoben, sowie die Vorteile der ZFS Appliance, die eine besser optimierte Performance durch spezielle Konfiguration und Integration in bestehende Systeme bietet. Besonders betont wird die Wichtigkeit von konsistenten Klonprozessen und die Berücksichtigung von Archiv-Logs sowie die Konfiguration der verschiedenen Pools zur Maximierung der Gesamtleistung.