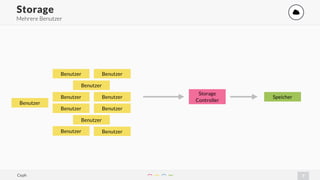

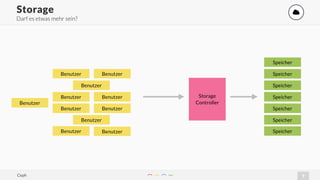

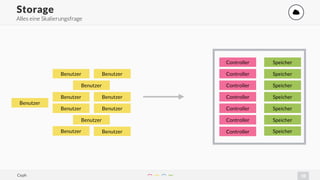

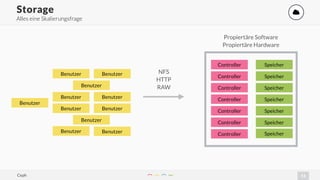

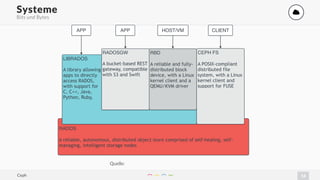

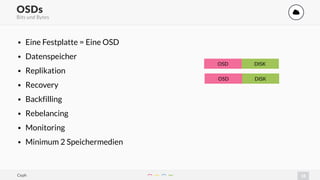

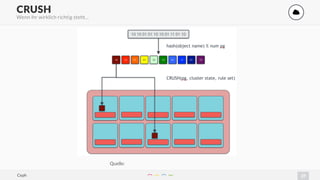

Das Dokument präsentiert Ceph, ein verteiltes Speichersystem, das seit 2014 als Lösung für Cloud-Speicher dient. Es behandelt grundlegende Konzepte, Sicherheit, Architektur und verschiedene Speichermethoden wie Block- und Objekt-Speicher. Zudem werden zentrale Komponenten wie OSDs, Monitore und MDS sowie deren Funktionalitäten und Vorteile für die Skalierbarkeit und Verteilung der Daten behandelt.