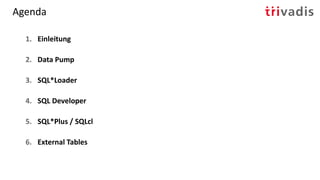

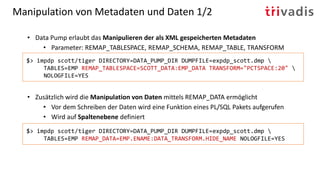

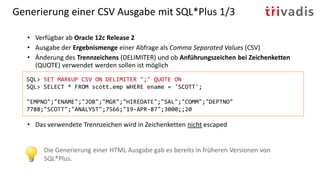

Das Dokument bietet einen umfassenden Überblick über Datentransfer-Methoden mit Oracle-Tools, insbesondere Data Pump, SQL*Loader, SQL Developer und SQL*Plus. Es beschreibt die Einrichtung, Nutzung und wichtige Parameter dieser Tools sowie die Bedeutung der Zeichenkodierung beim Datentransfer. Zudem werden Techniken zur Datenmanipulation und zur Nutzung externer Tabellen erklärt.