Das Dokument behandelt die Oracle Data Pump-Technologie zum Exportieren und Importieren von Datenbanken in den Versionen 10g, 11g und 12c. Es werden die Vorteile und Nachteile der alten Import-Export-Methoden im Vergleich zu Data Pump, die Architektur, sowie praktische Schritte und Überwachungsmethoden zur Anwendung von Data Pump vorgestellt. Zudem wird auf die Notwendigkeit des Zugriffs auf den Server und die Zugriffsrechte für den Export hingewiesen.

![Seite 32Gunther Pippèrr © 2015 http://www.pipperr.de

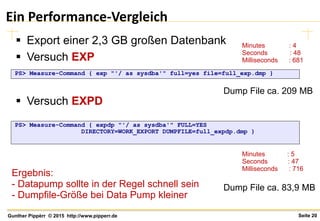

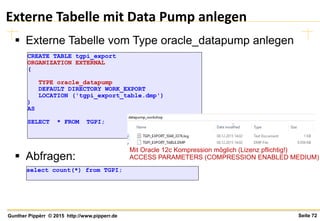

Export komprimieren

Parameter COMPRESION

– COMPRESSION=[ALL | DATA_ONLY | METADATA_ONLY |

NONE]

• ALL enables compression for the entire export operation. The ALL

option requires that the Oracle Advanced Compression option be

enabled.

• DATA_ONLY results in all data being written to the dump file in

compressed format. The DATA_ONLY option requires that the Oracle

Advanced Compression option be enabled.

• METADATA_ONLY results in all metadata being written to the dump

file in compressed format. This is the default.

• NONE disables compression for the entire export operation.

https://docs.oracle.com/cd/E11882_01/server.112/e22490/dp_export.htm#SUTIL838](https://image.slidesharecdn.com/03-datapump11g12cgpi2015-151216164539/85/Introduction-into-Oracle-Data-Pump-11g-12c-Export-and-Import-Data-32-320.jpg)

![Seite 35Gunther Pippèrr © 2015 http://www.pipperr.de

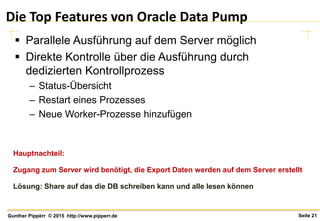

Nur Teile der Daten exportieren

Zum Beispiel um nur eine Teil der Produktion als Test

Daten einspielen, z.B. nur 10%

– Parameter

SAMPLE=[[schema_name.]table_name:]sample_percent

Nur bestimmte Daten exportieren

– Parameter

QUERY = [schema.][table_name:] query_clause

QUERY=employees:"WHERE department_id > 10 AND salary > 10000"

SAMPLE=scott.employees:10](https://image.slidesharecdn.com/03-datapump11g12cgpi2015-151216164539/85/Introduction-into-Oracle-Data-Pump-11g-12c-Export-and-Import-Data-35-320.jpg)

![Seite 38Gunther Pippèrr © 2015 http://www.pipperr.de

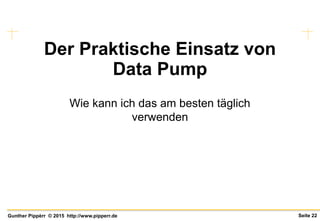

Filter für DB-Objekte

Erweiterte Auswahl von Filtern für DB-Objekte

– Mit include und exclude können für alle DB-Objekte

Filterregeln gesetzt werden

Siehe auch Metalink Doc ID 341733.1

EXCLUDE = object_type[:name_clause] [, ...]

INCLUDE = object_type[:name_clause] [, ...]

SCHEMAS=scott EXCLUDE=SEQUENCE, TABLE:"IN ('EMP', 'DEPT')"

SCHEMAS=scott INCLUDE=FUNCTION, PACKAGE, PROCEDURE, TABLE:"=

'EMP'"

Beispiele:

Entweder

include

ODER

exclude!](https://image.slidesharecdn.com/03-datapump11g12cgpi2015-151216164539/85/Introduction-into-Oracle-Data-Pump-11g-12c-Export-and-Import-Data-38-320.jpg)

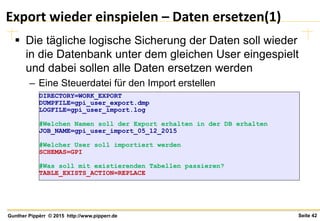

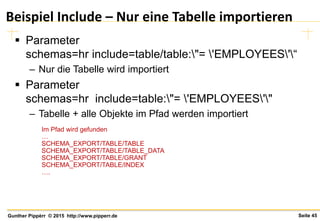

![Seite 43Gunther Pippèrr © 2015 http://www.pipperr.de

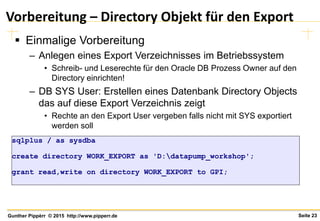

Export wieder einspielen – Optionen (2)

Was soll mit existierenden Tabellen passieren?

Parameter

– TABLE_EXISTS_ACTION=[SKIP | APPEND | TRUNCATE |

REPLACE]

• SKIP = Überspringen

• APPEND = Daten anhängen

• TRUNCATE = Lösche die Daten und importiere

• REPLACE = Drop Table und importiere

Default](https://image.slidesharecdn.com/03-datapump11g12cgpi2015-151216164539/85/Introduction-into-Oracle-Data-Pump-11g-12c-Export-and-Import-Data-43-320.jpg)

![Seite 52Gunther Pippèrr © 2015 http://www.pipperr.de

Job Control mit Ctr-C starten

Mit Ctrl-C kann der Job in den Interaktiven Modus

versetzt werden

The following commands are valid while in interactive mode.

Note: abbreviations are allowed

Command Description

------------------------------------------------------------------------------

ADD_FILE Add dumpfile to dumpfile set.

CONTINUE_CLIENT Return to logging mode. Job will be re-started if idle.

EXIT_CLIENT Quit client session and leave job running.

FILESIZE Default filesize (bytes) for subsequent ADD_FILE commands.

HELP Summarize interactive commands.

KILL_JOB Detach and delete job.

PARALLEL Change the number of active workers for current job.

PARALLEL=<number of workers>.

START_JOB Start/resume current job.

STATUS Frequency (secs) job status is to be monitored where

the default (0) will show new status when available.

STATUS[=interval]

STOP_JOB Orderly shutdown of job execution and exits the client.

STOP_JOB=IMMEDIATE performs an immediate shutdown of the

Data Pump job.](https://image.slidesharecdn.com/03-datapump11g12cgpi2015-151216164539/85/Introduction-into-Oracle-Data-Pump-11g-12c-Export-and-Import-Data-52-320.jpg)

![Seite 63Gunther Pippèrr © 2015 http://www.pipperr.de

Neue Feature mit 12c - Export

Eine View als Table

– Parameter

• VIEWS_AS_TABLES=[schema_name.]view_name[:table_name],](https://image.slidesharecdn.com/03-datapump11g12cgpi2015-151216164539/85/Introduction-into-Oracle-Data-Pump-11g-12c-Export-and-Import-Data-63-320.jpg)

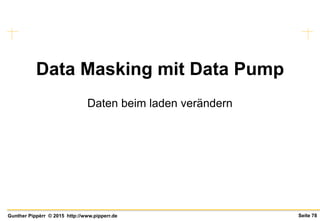

![Seite 79Gunther Pippèrr © 2015 http://www.pipperr.de

Daten beim Import manipulieren

Parameter REMAP_DATA

– REMAP_DATA=[schema.]tablename.column_name:[schema

.]pkg.function

Daten können bei Import mit einer in der DB

hinterlegten eigenen Funktion manipuliert werden

DIRECTORY=WORK_EXPORT

DUMPFILE=gpi_user_export.dmp

LOGFILE=gpi_user_import.log

#Welchen Namen soll der Export erhalten in der DB erhalten

JOB_NAME=gpi_user_import_05_12_2015

#Welcher User soll importiert werden

SCHEMAS=GPI

#Daten mit einer Funktion ersetzen

REMAP_DATA=hr.mitarbeiter.geburstdatum:hr.dataMappingFunction](https://image.slidesharecdn.com/03-datapump11g12cgpi2015-151216164539/85/Introduction-into-Oracle-Data-Pump-11g-12c-Export-and-Import-Data-79-320.jpg)