Das Dokument stellt die Big Data-Strategie von Oracle vor, die auf integrierte, schnelle und sichere Datenverwaltung aus verschiedenen Quellen abzielt. Es werden Technologien und Tools wie Oracle Big Data Connectors, Data Management Systeme und Analyseplattformen thematisiert. Zudem wird auf Herausforderungen und architektonische Konzepte im Bereich Data Warehousing und Big Data eingegangen.

![Oracle Big Data Statement of Direction (3)

DOAG 2015 - Oracle Big Data Connectivity7 17.11.2015

Ein paar Aussagen

“Oracle will provide fast, integrated, secure access to all data – not only data

stored in […] Exadata […] or Oracle Big Data Appliance, but also data stored in

operational NoSQL databases, transactional relational databases, streaming data

sources, and more.”

“Oracle will provide a framework for easily incorporating new data sources,

ensuring that these new data sources can be seamlessly accessed and managed”

“Strategy is to extend its existing in-database features (such as its data dictionary,

SQL query engine, query optimizer, resource manager, and data optimization) in

order to manage the entire Big Data Management System”](https://image.slidesharecdn.com/bigdataconnectivityeinfuehrungunddemosfuerdieoracleplatform-peterwelker-151209144806-lva1-app6892/85/Big-Data-Konnektivitat-7-320.jpg)

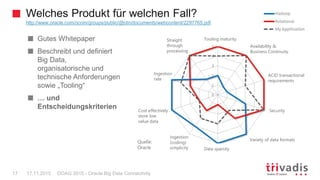

![OSCH „ExternalTable“ Syntax & more

DOAG 2015 - Oracle Big Data Connectivity24 17.11.2015

Nur SELECTs

Paralleles Lesen bei mehreren Files unterstützt

External Table Funktionalität (bspw. Formatmasken, Datenkonvertierung usw.)

Es werden immer FULL TABLE SCANs durchgeführt

– Also kein PushDown von Filtern aus WHERE Clauses, keine Indexe usw.

hadoop jar OSCH_HOME/jlib/orahdfs.jar

oracle.hadoop.exttab.ExternalTable

[-conf config_file]...

[-D property=value]...

-createTable [--noexecute [--output filename.sql]]

| -drop [--noexecute]

| -describe

| -publish [--noexecute]

| -listlocations [--details]

| -getDDL

OSCH](https://image.slidesharecdn.com/bigdataconnectivityeinfuehrungunddemosfuerdieoracleplatform-peterwelker-151209144806-lva1-app6892/85/Big-Data-Konnektivitat-24-320.jpg)

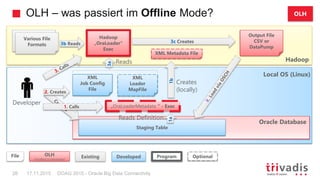

![OLH Setup

DOAG 2015 - Oracle Big Data Connectivity26 17.11.2015

Installation von Hadoop Client und OLH auf DB Server

– http://docs.oracle.com/cd/E63064_01/doc.42/e63063/start.htm#BDCUG115

Danach generiert OLH Zugriffsmechanismen und –objekte und führt den

Ladevorgang aus, wenn gewünscht (Online Mode)

OraLoader Tool in Hadoop ausführen

– Provide OraLoader with information about the Hadoop data source, the table definition in the

Oracle Database and various optimizations in one or two separate XML files

– Es ist ein Aufruf eines Java Programms mittels Hadoop client

hadoop jar -- hadoop Befehl

$OLH_HOME/jlib/oraloader.jar -- Tool aus folgender Bibliothek

oracle.hadoop.loader.OraLoader -- Name des Tools (Java Programm)

-conf /home/oracle/movies/jobconfig.xml -- Param: XML mit Loaderdefinition

[-libjars input_file_format1.jar[,...]] -- MapReduce Input Definitionen

OLH](https://image.slidesharecdn.com/bigdataconnectivityeinfuehrungunddemosfuerdieoracleplatform-peterwelker-151209144806-lva1-app6892/85/Big-Data-Konnektivitat-26-320.jpg)

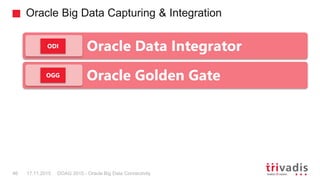

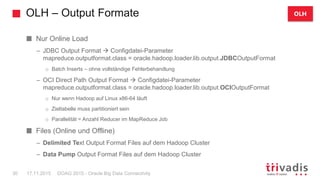

![Big Data SQL

DOAG 2015 - Oracle Big Data Connectivity35 17.11.2015

Abfragen bspw. Gegen Apache Hive, HDFS, Oracle NoSQL Database oder Apache

HBase [via Hive Metadata]

Gemeinsames Analysieren von Daten aus diversen Datenspeichern ”as if it were all

stored in an Oracle database”

– Die vollständige Oracle SQL Syntax kann genutzt werden (auch AAO etc.)

– Der Zugriff erfolgt via External Tables (wie bei OSCH), unterstützt aber darüber hinaus

„SmartScans“ (bspw. Filter Predicate Offload)

Zwei Varianten sind verfügbar

– Oracle Big Data for Hive (für Hive – und HBase – Konnektivität)

– Oracle Big Data SQL Server (für freien Zugriff mit SmartScan Funktionalität)

Benötigt Installation von Oracle Komponenten auf dem Hadoop Cluster

Aktuell limitiert auf die Kombination Exadata Big Data Appliance!

OBDS](https://image.slidesharecdn.com/bigdataconnectivityeinfuehrungunddemosfuerdieoracleplatform-peterwelker-151209144806-lva1-app6892/85/Big-Data-Konnektivitat-35-320.jpg)