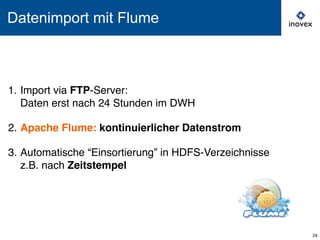

Das Dokument behandelt die Implementierung von Hadoop als Datenlager-Backend bei ProSieben, einschließlich der Integration von Datenquellen wie Weblogs und sozialen Netzwerken durch ein hybrides System aus relationaler Datenbank und Hadoop Cluster. Es werden ETL-Prozesse mit Pentaho Data Integration (PDI) sowie Datenimporte über Apache Flume erläutert, um große Datenmengen effizient zu verwalten. Zudem wird Apache Hive zur Aggregation und Analyse der Rohdaten vorgestellt, mit dem Ziel, neue Metriken und Datenanomalien zu identifizieren.

![Java: Mapper und Reducer

17

public class WebtrekkEventMapper

extends Mapper<Text, Text, Text, IntWritable> {

@Override

protected void map( Text key, Text value, Context context )

! throws IOException, InterruptedException {

! // key contains entire record

! String[] fields = key.toString().split( ";" );

! // extract relevant information

! String eventname = fields[12];

! // emit output key and count

! context.write( new Text( eventname ),

! ! new IntWritable( 1 ));

}

}

public class IntSumReducer

extends Reducer<Text, IntWritable, Text, IntWritable> {

!

@Override

protected void reduce( Text key, Iterable<IntWritable> values,

Context context )

throws IOException, InterruptedException {

! int sum = 0;

! for ( IntWritable partialCount : values ) {

! sum += partialCount.get();

! }

! context.write( key, new IntWritable( sum ) );

}

}](https://image.slidesharecdn.com/fusion-der-welten-kathrin-spreyer-osbi-workshop-02-2014-140311070504-phpapp01/85/Fusion-der-Welten-Hadoop-als-DWH-Backend-bei-ProSieben-21-320.jpg)

![Java: Mapper und Reducer

17

public class WebtrekkEventMapper

extends Mapper<Text, Text, Text, IntWritable> {

@Override

protected void map( Text key, Text value, Context context )

! throws IOException, InterruptedException {

! // key contains entire record

! String[] fields = key.toString().split( ";" );

! // extract relevant information

! String eventname = fields[12];

! // emit output key and count

! context.write( new Text( eventname ),

! ! new IntWritable( 1 ));

}

}

public class IntSumReducer

extends Reducer<Text, IntWritable, Text, IntWritable> {

!

@Override

protected void reduce( Text key, Iterable<IntWritable> values,

Context context )

throws IOException, InterruptedException {

! int sum = 0;

! for ( IntWritable partialCount : values ) {

! sum += partialCount.get();

! }

! context.write( key, new IntWritable( sum ) );

}

}

Mapper

Reducer

(+Driver)](https://image.slidesharecdn.com/fusion-der-welten-kathrin-spreyer-osbi-workshop-02-2014-140311070504-phpapp01/85/Fusion-der-Welten-Hadoop-als-DWH-Backend-bei-ProSieben-22-320.jpg)