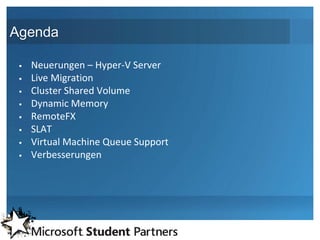

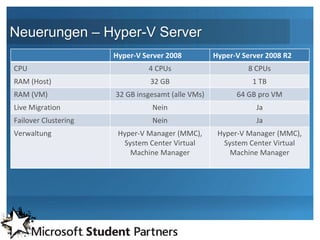

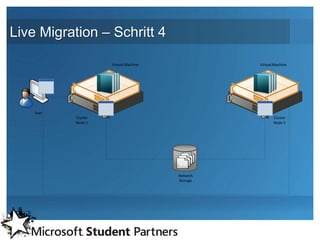

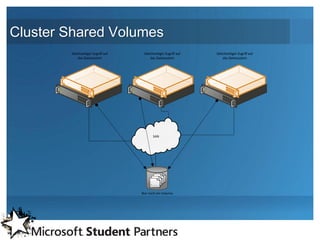

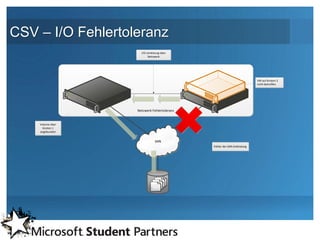

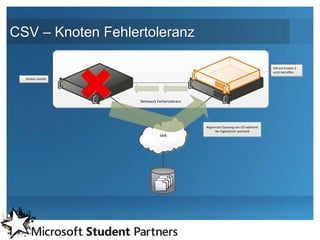

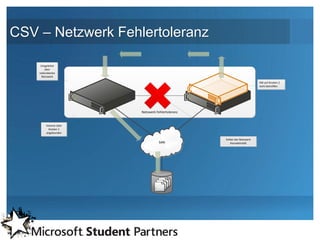

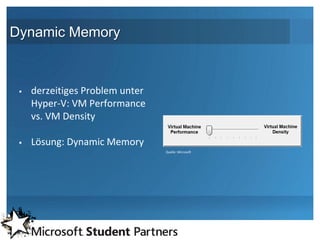

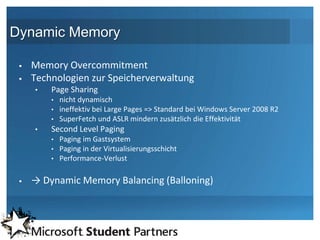

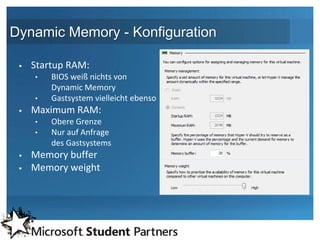

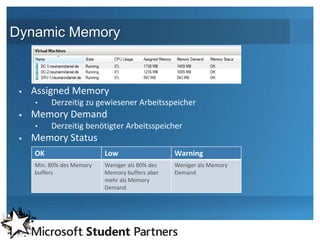

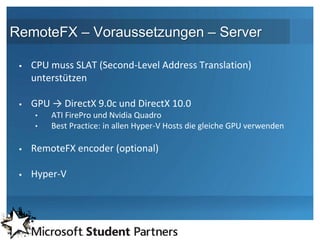

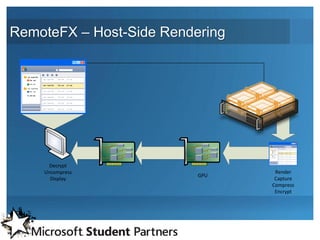

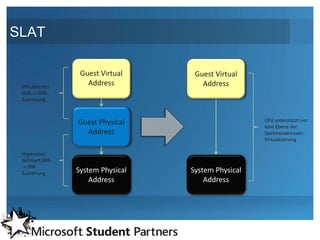

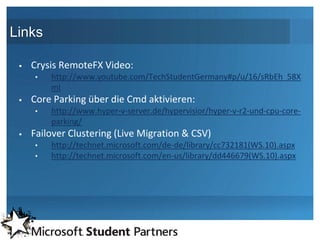

Das Dokument beschreibt die Neuerungen und Verbesserungen von Microsoft Hyper-V Server 2008 R2 SP1, einschließlich Funktionen wie Live Migration, Cluster Shared Volumes, Dynamic Memory und RemoteFX. Es werden technische Details und Konfigurationen erläutert, die zur Optimierung der Virtualisierungsleistung und -verwaltung beitragen. Der Autor, Daniel Neumann, ist ein Microsoft Expert Student Partner und studiert an der Fachhochschule Köln.