In diesem Bericht wird die Entwicklung eines parallelen und objektorientierten Simplex-Algorithmus zur Lösung von linearen Programmen (LPs) beschrieben, der auf dem Cray T3D Rechner implementiert wurde. Die Arbeit behandelt die numerische Stabilität der Algorithmen und zeigt Verbesserungen bei der Effizienz und Stabilität der Implementierungen durch den Einsatz spezieller Datenstrukturen und Techniken. Neben der sequentiellen Version werden auch parallele Implementierungen vorgestellt, die beschleunigte Lösungen für dünnbesetzte lineare Gleichungssysteme bieten.

![letu

er Anfang der Lnearen Programmerung als mathematsche Disziplin läßt sch genau auf

das Jahr 1947 datieren, in dem G.B. Dantzig das erste Lneare Programm (LP) aufstellte

und den Smplex-Algorthmus als Lösungsverfahren formulierte. Zu dieser Zeit verwendete

man den Begriff Programm noch nicht in sener heutigen Bedeutung als Ausführungscode

für Computer. Vielmehr verstanden d e Mlitärs unter einem Programm enen Plan zur

Ressourcenverteilung; das erste von G.B. antzi aufgestellte Lineare Programm war eben

militärisches Planungsroblem.

Berets vor 1947 gab es verenzelte Arbeiten, heute der Lnearen Programmerung

zugeordnet werden müssen. Se bleben jedoch ohne Auswrkung auf die F o r t e n t w l u n g

der Mathematik w e die Arbeiten von Fourier 1823 und de la Vallee Poussin 1911, oder

wurden aus polsch-ideologischen Gründen ncht vorangetrieben (Kantorovch 193) [32]

neare Programme snd O e r u n g s r o b l e m e , d e Form

min cTx

s.t. Ax b,

x

gebracht werden önnen Dabei i t A ne Matr und c, b und x snd mensionskompatible

Vektoren. Schon bald stellte sich heraus, daß Lineare Programme weitreichende Anwen-

dungen n zahlreichen wirschaftlchen und gesellschaftlichen Gebieten haben, wi bei der

Transport- und Netzwerkpanung, der Ressourcenvertelung oder be Scheduling, um nu

nige zu nennen. 1949 faßte R Dorfman dese Gebite mit dem Begriff der mathematischen

Programmierung zusammen [32]. E n zentraler Tel davon ist die Lineare Programmerung,

deren Gegenstand die algorthmische Lösung von LPs ist. Solche treten oft bei der Lösung

mathematscher Programme auf. Dabei dient der (im Laufe der Zeit weiterentwickelte

Simplex-Algorthums bis heute als „Arbetspferd". Die heutige Bedeutung von LP-Lösern

zegt sch z.B. darin, daß 1995 mindestens 9 verschiedene Implementierungen kommerzell

angeboten wurden [88]

Obwohl n vielzählgen Anwendungen bewährt, der Splex-Algorthmus besonders

für Mathematiker nicht zufriedenstellend. Dies liegt daran, daß seine Laufzeit ncht be-

friedigend beschränt werden kann. Berets in den 50er Jahren wurde von A J . Hoffman

n LP angegeben, für das der damalige Splex-Algorthmus nicht terminier [65] Dieses](https://image.slidesharecdn.com/soplex-tr-100422010730-phpapp02/85/Soplex-tr-17-320.jpg)

![Einleitung

Problem des sog. K i n s konnte zwar durch spezelle Varianten umgangen werden ür

die meisten solcher Varanten gibt es aber Problembeispiele, die ein nicht polynomales

Laufzeitverhalten aufwesen. Alle bekannten Beispiele werden in [2] nhetlch zusammen-

gefaßt. Be vielen praktischen Problemen zeigt sch hingegen ne polynomale Laufzeit, was

auch durch statstsche Analysen untermauert werden kann [1]. Ob es jedoch polynomiale

Simplex-Algorthmen gibt, ist eine b s heute ffene Frage 70, 104]

eshalb wurde lange der Frage nachgegangen, ob Lneare Programme überhau po-

lynomaler Zeit gelöst werden können Diese Frage wurde 1979 von L.G. Khachian durch

Angabe der Ellipsoid-Methode positv beantwortet [69, 54]. Trotz ihrer theoretsch überle-

genen Laufzeit konnte die Ellipsoid-Methode oder deren Varianten in realen Anwendungen

ncht mit dem Simplex-Algorthmus konkurieren, und so beschränte sch die Fortentwick

lung der Linearen Programmerung noch wetere fünf Jahre iw. auf Verbesserungen des

Simplex-Verfahrens.

Viellecht durch die Ellipsod-Methode angespornt, stellte N . Karmarkar Jahr

1984 m t einem Innere-Punte-Verfahren einen anderen polynomalen LP-Löser vor [67]

nnere-Punkte-Verfahren wurden bereits set den 60er Jahren zur Lösung nichtlnearer Op

imerungsrobleme eingesetzt [44], jedoch wurden sie erst set 1984 für den lnearen Fall

ezialisiert und seither zu ner mächtigen Konkurrenz zu Splex-Algorithmen fortent-

kelt [76, 87]. Derzeit snd die Innere-Punkte-Verfahren und der Simplex-Algorithmus

glechermaßen etablert, und für viele Anwendungen ist ene Kombinaton beider Metho-

den mttels eines sog. Crossovers e beste Wahl [ 16]

Unabhängg von den Erfolgen der nnere-Punte-Verfahren komm dem implex-

Algorithmus auf absehbare Z i t ene nicht zu vernachlässgende Bedeutung zu. So liefert er

zusätzlich zu einer optimalen Lösung des LPs weitere Informationen wie die Schattenpreise,

die, ökonomisch nterpretiert, eine bessere Beurtelung der Lösung erlauben Darüberhn-

aus werden Splex-Algorthmen n Schnittebenen-Verfahren zur Lösung ganzzahliger Op-

timierungsprobleme eingesetzt. abei wrd eine Folge von jeweils leicht modifizierten LPs

generiert und gelöst. Nur der Splex-Algorthmus ist hierbei in der Lage, auf dem Ergeb-

n s des vorigen LPs aufzusetzen, um das jeweils neue LP schneller zu lösen Deshalb blebt

e Weiterenticklung des Smplex-Algorthmus' ein ständig atuelles Forschungsthema.

Di Verbesserungen des S l e x - A l g o r t h m u s ' haben se sener Erfindung Beachtlches

zustandegebracht. 1953 feierte man die Lösung eines 48 x 72 LPs noch mit Wein und

Schmaus [65 Heute werden auch LPs mit über 100000 Z l e n und Spalten routinemäßig

gelöst, und die Entwicklung immer ausgeklügelterer Verfahren, mit denen immer größere

LPs m immer kürzerer Ze gelöst werden können, ält weter an. Auch ie vorliegende

Arbet trägt dazu be

G.B. Dantzig formulerte den Splex-Algorithmus m t dem sog. Simplex-Tleau Dies

im wesentlchen eine Matrix, d e n jeder Iteration des Algorthmus' vollständg aktua

siert wrd. E n bedeutender Meilenstein be der Entwicklung des Simplex-Algorthmus'

bestand n der Formulierung des revidierten mplex-Algorthmus', be dem mmer nur ei](https://image.slidesharecdn.com/soplex-tr-100422010730-phpapp02/85/Soplex-tr-18-320.jpg)

![Einleitung

l des Tableaus, d e sog. B a s s m a t r i , aktualiert wrd Dafür üssen pro teraton zwe

Gleichungssysteme mit der Bassmatrx gelöst werden ennoch kann gezegt werden, daß

der Gesamtaufwand geringer ausfällt.

n weterer wichtiger Vorteil des revdierten Splex-Algorithmus' gegenüber der Ta

bleauform st, daß er es erleichtert, Datenstrukturen für dünnbesetzte Matrizen zu verwen-

den, also solche m t vielen Null-Elementen. Typischerweise haben die Nebenbedingungsma-

trizen A heutiger LPs nur 1-2 Ncht-Null-Elemente pro Spalte oder Zeile, ggf. mit einigen

Ausnahmen Insgesamt sind wet weniger als 10% der Elemente von Null verscheden. Be

der A k t u a l e r u n g der Tableaus ohne Ausnutzung der Dünnbesetztheit würden viele Re-

chenoeratonen mit Null-Elementen durchgeführt, e Aufwand, der vermieden werden

sollte.

ne wetere Verbesserung bestand n der Enführung der LU-erlegung der Bassmatrix

für ie Lösung der beden Linearen Gleichungssysteme in jeder teration des revidierten

Simlex-Algorithmus' [77]. Ursprünglich verwandte man d e sog. Produktform der Inver

sen [29]. Für dünnbesetzte Matrizen wurde jedoch gezeigt, daß diese zu mehr Nicht-Null-

Elementen führt als e LU-Zerlegung und somit einen höheren Rechenaufwand bedingt

[11]

Berets 195 wurde von .E. Lemke der duale Siplex-Algorthmus angegeben. Heu-

te st er fester Bestandteil aller effizenten Implementierungen, ncht zuletzt weil er ene

wesentlche Grundlage für die Implementerung von Schnittebenenverfahren darstellt.

ine chtge Verbesserung des Simplex-Algorthmus' war sene Erweterung auf LPs,

be denen die Varablen cht nur untere, sondern auch obere Schranken aufweisen können

Außerdem werden für die Varablenschranken auch von Null verschiedene Werte zugelassen

Das Verfahren wurde 1955 von G B . Dantzg selbst aufgestellt und ist als pperboundin

Technik bekannt.

Das P r n g ist ein wchtger Schrtt beim Simlex-Verfahren, der e g e F r e h e t zuläßt.

aher verwundert es ncht, daß sich eine Vielzahl von Verbesserungsvorschlägen um eine

Konkretierung bemühen, die d Iterationszahl des Algorithmus' reduzieren oder sene

Termnaton sicherstellen sollen Be der ersten Kategorie snd insbesondere d e Arbeten

von P.M.J. Harris ] sowie von D. Goldfarb und J.K Rei [52] bzw. J.J. Forest und

D. Goldfarb [47] zu nennen. Sie befassen sich mit Varianten des sog. steepest-edge Pri

cings, für das schon lange bekannt war, daß es zwar zu einer bemerkenswert geringen

terationszahl führt, dafür aber eines hohen Rechenaufwandes bedarf [71]. Harris stellt e

pproximatives Verfahren vor, das wesentlch weniger Operationen bedarf. Goldfarb und

R entwickeln für den primalen Algorithmus Update-Formeln, die den Rechenaufwand

b e m steepest-edge P r i n g mindern In 7] wurden diese auch für den dualen Algorithmus

aufgestellt.

plex-Varanten, d e ene Terminaton des Splex-Algorthmus' zuschern, benutzen

m e t ene Kombination von Verfahren für den Prcing-Schritt und den sog. Quotiententest.

Bedes wird mit dem Begri ivotRegel zusammengefaßt. Erste Ansätze zur garantierten](https://image.slidesharecdn.com/soplex-tr-100422010730-phpapp02/85/Soplex-tr-19-320.jpg)

![Einleitung

Termnaton des Splex-Algorthmus' waren e Perturbatonsmethode von Orden und

harnes [24] sowie d e Lexikographische Methode von Dantzig, Orden und Wolfe [30]

Mit der Arbet von Bland 17] begann eine verstärkte Untersuchung von Pivotregeln, d

ne endliche Laufzeit des S l e x - A l g o r i t h m u s ' garantieren. Eine Überscht findet sich

[94] Insgesamt wurde noch n theorescher Ansatz gefunden, der auch in der Praxi

befiedigt. Deshalb werden n heutigen plementierungen Verfahren eingesetzt, die sch

in der Praxs bewährt haben, aber auf ner theoreischen Grundlage basieren 50, 16

Der Quotiententest i auch der Schrtt bei Silex-Algorithmen, der di numersche

S t a b i l ä t des Verfahrens bestmmt. Wenn auch ohne theoretische Stabilitätsanalyse, wur-

de der wesentlche Ansatzunkt zur Gewährleistung der numerischen Stabilität n [60

aufgezeigt. Er st bis heute di Grundlage für robuste Imlementerungen 50, 16]

E n wichtges Arbeitsfeld bei der F o r t e n t k l u n g von Siplex-Algorithmen ist deren

pezalisierung auf LPs t ausgezechneter S t r u t u r . Wichtgstes Beispiel sind Netzwer

probleme, für die der sog. Netzwer-Simplex entwickelt wurde, der von den Datenstru

turen her kaum mehr an Dantzig's Algorithmus ernner [26. E n anderer Spezialfall snd

MultiCommodity-Flow Probleme. Bei desen Problemen zerfällt die Nebenbedngungsma

trix Diagonalblöcke, die durch wenge Z l e n verbunden sind. Herfür wurde von Dantz

und Wolfe eine Dekompostionsmethode entwikelt, bei der iteratv zu jedem Diagonalbloc

ein LP gelöst wrd, um aus diesen Teillösungen ne verbesserte Lösung des Gesamt-LPs zu

konstruieren [ ] . Gerade in der Zeit des Aufkommens von Parallelrechnern, bei denen die

Teilprobleme von verschiedenen Prozessoren berechnet werden können, wurde ies weder

aufgegriffen [74]

Es g b t noch ne Vielzahl weterer Arbeten mi Modikatons- oder Verbesserungs-

vorschlägen zum Simplex-Algorithmus. Den meisten dieser Arbeiten ist jedoch gemein,

daß die evtl. angegebenen Implementierungen nicht alle oben genannten Verbesserungen

enthalten, sondern oft nur auf dem Grundalgorithmus von Dantzig baseren oder sich m

diesem vergleichen (siehe z.B. [25, 37, 82 4]). eshalb bleben diese Ansätze weitgehend

für d e Lösung p r a s c h e r Probleme irrelevant.

Um zur Fortentwklung von Simplex-Algorthmen beizutragen, muß zunächst auf dem

sher geschilderten Stand aufgesetzt werden Dies leiten die in der vorliegenden Ar-

beit entwckelten Implementierungen, und s e treben e Fortenticklung von Simplex-

Algorithmen auf verschieden Ebenen voran

Auf konzeoneller Ebene baseren die plementerungen auf ener neuen arstel-

lung des primalen und dualen mplex-Algorithmus mithilfe einer Zeilenbasis, aus

der die üblche arstellung m t ener Spaltenbasis als Spezalfall folgt. Die gewählte

Darstellung ermöglcht eine einheitliche Formulerung beder Algorithmen für bei

de Arten der Basis und wurde den mplementierungen zugrundegelegt. Desweiteren

wird ene theoretsche Stabiliätsanalyse des Smplex-Verfahrens durchgeführt, und

es werden Methoden der S t a b i e r u n g aufgezegt. Außerdem verwenden die Imple-

menterungen ein Phase 1 LP, das eine größtmöglche Überenstmmung m dem zu

lösenden LP aufweist.](https://image.slidesharecdn.com/soplex-tr-100422010730-phpapp02/85/Soplex-tr-20-320.jpg)

![Einleitung

Auf Iplementierungsebene kommt ein verbesserter Lösungsalgorthmus für lneare

Glechungssysteme mit extrem dünnbesetzten Matrizen und Vektoren zum Ensatz.

Außerdem wird der Zeitpunkt der erneuten Faktorierung der Bassmatr dyna

misch so festgelegt, daß d e terationsgeschwndket maximiert wird

n software-technscher Hinsicht rd der Splex-Algorthmus enem objetorienter-

ten Entwurf unterzogen Dieser b t e t eine hohe Flexibität und Anpaßbareit, durch

d e es z.B. möglch ist, benutzerdefinierte Pricing- oder uotiententest-Verfahren en-

zusetzen

Als Hardware kommen auch moderne Parallelrechner zum Ensatz. Dies fügt sich

die Tradition der Entwicklung von Simplex-Algorithmen, die stets eng it den jewe

gen Hardwarevoraussetzungen verbunden war. So entwikelte antzg den Simplex-

Algorithmus nur wegen der in Aussicht stehenden V e r f ü g b a r t automatscher Re-

chenmaschinen [32]

Die hier untersuchte Parallelerung setzen an vier Punkten an: Am enfachsten ge-

taltet sich d e Parallelsierung elementarer Operationen der linearen Algebra auf

ünnbesetzten Daten, w die Berechnung des Matrix-ektor-Produktes oder die

Vektorsumme. Dies wurde bereits in anderen Arbeiten erfolgrech durchgeführt [13]

Außerdem kommen in dem Prcing- und Quotiententest-Schrtt parallele Suchalgo-

rithmen zum Einsatz. Ferner werden mit dem BlckPivoting mehrere sequentielle

Iterationen zu einer parallelen zusammengefaßt. Schließlich werden öglichkten

zur parallelen ösung von Glechungssystemen betrachtet. Dabei rd sowohl die

glechzeitge Lösung verschiedener Systeme sowe d e Parallelisierung enes auf der

LU-Zerlegung basierenden Lösers vorgenommen

Es werden drei Implementerungen von r e e r t e n S l e x - A l g o r t h m e n für versche-

dene Hard ware-Archteturen vorgestellt. Sie heßen

Solex für equental bject-orented s l e x

Dolex für strbuted bject-orented s l e x " und

SMlex für hared emory bject-orented s l e x

SoPlex t also ene plementerung für normale s oder W o r t a t o n s mit enem Pro-

zessor. Se enthält alle Konzepte von state-ofthe-art Simplex-Algorithmen nclusive der in

eser Arbeit geleisteten Fortentwicklungen. Wo diese grefen, können Geschwndgkeitsge-

winne gegenüber anderen Imlementerungen e PLEX 27] erzielt werden Damt egne

ch SoPlex für die Benutzung im täglchen Ensatz.

er objektorentierte Entwurf ermöglcht es, alle Egenschaften von SoPlex den ple-

mentierungen DoPlex für Parallelrechner mit verteiltem Speicher und SMoPlex für solche

mit gemeinsamen Speicher zu vererben, nsbesondere seine numerische Stabilität. Für bede

arallele Versionen wurden alle o.g. Parallelierungsansätze imlementert.](https://image.slidesharecdn.com/soplex-tr-100422010730-phpapp02/85/Soplex-tr-21-320.jpg)

![aptel

idierte i m l e x - A o r e n

n desem Kapitel werden Splex-Algorthmen, genauer r e d i e r t e Splex-Algorthmen,

von der Theorie bis hin zur praktischen Umsetzung beschreben abe werden sowohl

primale als auch duale Algorthmen jewels für zwei verschiedene arstellungen der Basis

behandelt.

unächst wird Abschntt 1.1 die verwendete Notaton engeführt, und es werden

für Smplex-Algorithmen grundlegenden Sätze der Polyedertheorie zusammengestellt.

arauf aufbauend werden n Abschnitt 1.2 Smplex-Algorithmen m t verschiedenen ar-

stellungen der Basis entwikelt. Um zu lauffähgen mplementierungen zu gelangen, müssen

noch wetere Aspkte b e r ü c i c h t g t werden. Zunächst ist dies die numersche Stabilität,

die n Abschnitt 1.3 analysiert ird. Dor werden auch verschedene Ansätze vorgestellt, um

plex-Algorithmen stabl zu machen. Weiterhin muß n geeigneter Start für S l e x -

Algorthmen gefunden werden Dies gescheht mit der Phase 1, die n Abschnitt 1. d i u -

tiert wird. Schließlich bergen Smplex-Algorithmen das Problem, daß sie evtl. nicht termi-

eren. Strategen dagegen werden n Abschnitt 1.5 vorgestellt. Bei sog. Pricng beten

implex-Algorithmen eine große algorithmische Vielfalt; d wichtgsten Strategien dafür

werden n Abschnitt 1.6 vorgestellt. Auch e numerische ösung linearer Gleichungssy-

steme t ein integraler Bestandte jeder plementerung von Simplex-Algorthmen Da

esem Problem eine Bedeutung we über Smplex-Algorithmen hinaus zukommt, wrd es

n einen eigenen Abschitt, nämlich 1.7, behandelt. Schließlch werden in Abschnitt 1.8 ver-

scheden Tips und T r s für eine effiziente und zuverlässige Implementierung beschreben

1.1 tation und themtishe rundlagen

n diesem Abschntt werden wesentlche Begr und Sätze der Polyedertheore zusammen-

gestellt, und es wrd d e Notaton dazu eingeführt. Dies geschieht in enger Anlehnung an

[55], worauf auch für d e Bewese der hier nur zitierten Sätze verwesen wird. Zuvor sei auf

folgende Schreibweisen hingewesen:](https://image.slidesharecdn.com/soplex-tr-100422010730-phpapp02/85/Soplex-tr-23-320.jpg)

![KAPITEL 1. REVIDIERTE SIMPLEX-ALGORITHMEN

Di nhetsmatr wird mit / bezeichnet. hre Dimension st allgemenen aus

dem Zusammenhang erschtlich; andernfalls wrd ie durch nen ndex angegeben

Somit bezeichnet In d e rt-dmensionale Einhetsmatrix

ür toren, die nur aus den Werten 1 oder nur aus den Werten 0 bestehen, rd

kurz 1 bzw. 0 geschrieben, wobe Dimension wiederum aus dem Zusammenhang

ersichtlich ist.

Ferner bezeichnet e* den zten E n h e t s v e t o r , wederum der aus dem usammen-

hang vorgegebenen Dimenson

Lineare rogramme nd erungsrobleme der Form

min

1.1

t.

wobe c,x G R , d G Rk und D G R*x seen. Falls es für jedes M G R x GR

gibt, so daß cx < M und Dx > d gilt, so heißt das LP unbeschränkt t hingegen

x G R : Dx > d} = 0, so heißt es unzulässig.

D^ bezechne den i-ten Z l e n v e t o r der Matrx D, Dj entsprechend hren j-ten

altenvetor. Jede Nebenbedngung D^ > dj, mit Z / definert einen Halbraum

n n

i = {x G R : Di.x > di} des R , und d e Hyperebene Gt = x E W : Dix = di} wird

e zugehörige Hyperebene genannt. Lösungsvektoren x von (1.1) müssen alle Nebenbedn-

gungen erfüllen und legen somit im Schnitt aller Halbräume "%, i = , . . . , k. Der Schnitt

von endlch velen Halbräumen st e n Polyeder und wird mi

,d P x G R : D > d} 1.2)

bezechnet. as olyeder , d) heßt das zum 1.1) gehörende Polyeder. Ferner wer-

den später auch Polyeder T , d ) = {x G R : D = d, x > 0} und V{l,D,u = {x G

Rn : l < x < u) benötgt.

ne wichtge Egenschaft von Polyedern st, daß s e ncht nur als Schntt von Halbräum-

en dargestellt werden können. Vielmehr kann jedes Polyeder aus zwe Grundtypen von

Polyedern aufgebaut werden Dies sind für X = x,... xm}

cone x G R : Y7=i Kx» 0} und

conv xtR : Y!t=i ^ >l !}>

wobe xi,..., xm toren und A i , . . . , A kalare bezeichnen, cone X) heßt der von den

Vektoren x^,... ,xm aufgespannte Kgel und conv (X) ihre onvexe Hülle Beide Mengen

nd Polyeder. Für Polyeder P] und P 2 bezeichnet P1P2 = xi+x2 : x G P, x2 G P2}

hre MinkowskiSumme](https://image.slidesharecdn.com/soplex-tr-100422010730-phpapp02/85/Soplex-tr-24-320.jpg)

![1.. DI GRUNDALGORITHMEN 15

Entsrechend gelten 1.10 und 1.11, denn durch Ensetzen ' erhält man

cj>(r-e

4>{rD~l - e

T

( r 1 - e c/>(r - e

T

</>(rD--e(r D--eT)

f 9(r - D + <j>{rT - D + < D - ( r - D

( r ( r - D

( r

ie ilesismatri folg iese tz

SATZ 6 (ZEILENBASISTAUSCH

Sei Z = (P, Q) eine Zeilenbasis zum LP (1.1) Seien i e { 1 , . . . , n} und j 6 Q

Dann ist Z' = (P1, Q') mit P = P {Pi} U {j} und Q' Q {j} U {P;} genau

dann eine Zeilenbasis von (11) enn

Dj p])i ± 1.13)

(Z (Z) + @(l,3)-)i 1.14)

{Z (Z) + Si,j) Dp}) und 1.15)

T T

y (Z y {Z) + ^ h j ) D j - ] - e 1.16)

d

i Sj{Z

M) 1.17)

D3.D-])%

VijZ

und i,j) 1.18)

Dip})i

EWEIS:

Bis auf (1.15) folgt alles aus Satz 5, und zwar mit DP_, D = P>p' 9 = i,j),

<f> = $i,j), f = x{Z), f = x{Z% f = dPlg = (Z), g {Z% g = c p = dj, = D3

und l = i. Gleichung 1.15) gilt dann wegen (Z') (Z') {Z) + ®i,j)Dp})j.](https://image.slidesharecdn.com/soplex-tr-100422010730-phpapp02/85/Soplex-tr-31-320.jpg)

![. D R U H M E 21

BEWEIS:

Terminiert Algorithmus 1 in Schritt dann ist h nach Satz 8 ein optimaler Lösungsvek-

tor von LP 1.1). Wenn Algorithmus in Schritt terminier ist das LP nach Satz

unbeschränkt. Da Agq = AT(A1eq = (AT)q_(AT)E]1ep Afp gilt schließlich nach

den Sätzen 6 und 9, daß in Schritt 6 Z wieder eine zulässige Basis mit dualen Variablen

/ , Schlupfvariablen und Lösungsvektor is so daß die Voraussetzungen für Schritt

wieder erfüllt sind

•

Aufgrund von Gleichung (1.24) hat nach jeder Iteration der neue Lösungsvektor h

höchstens denselben Zielfunktionswert wie h. Für dq ^ gq ist er kleiner, während sons

h = h! gilt, d.h. derselbe Lösungsvektor wird von dem neuen Satz von asishyperebenen

definiert. Solch ein Pivot-Schritt heißt degeneriert. Er ist nur möglich wenn sich beim

Basislösungsvektor mehr als Stützherebenen von V(D, d) schneiden Solch eine cke

heißt primal deeneriert

1.2.1.2 ualer Algorithmus

Gegensatz zum primalen Algorithmus arbeitet der duale auf einer optimalen Basis

h. Gleichung (1.21) ist erfüllt. Sofern die Basis nicht auch zulässig ist, gibt es eine verletzte

ngleichung, etwa q. Sie soll in die Basis aufgenommen werden. Dazu muß eine andere die

asis verlassen und zwar so, daß die neue Basis wieder optimal ist. Anschaulich ist es die

Basisungleichung mit der der neue Lösungsvektor einen minimalen Zielfunktionswert

aufweist (vgl Abb 1.5). Nach den Gleichungen (1.14) und (1.17) uß p also so gewählt

werden daß x(Z') = cTx(Z) + Q(pq)(cDp) und somit Q(p,)-(cTDp^)p = y(Z)pdq —

(Z))/(Dg.Dp^ minimiert wird. Da aber dq > sq(Z), ist dies gleichbedeutend mit der

inimierung von (Z/(DqDp^. Dies wird von folgenden Satz präzisier

SATZ 11 ( U A L E R QUOTIENTENTEST FÜR EINE ZEILENBASIS)

Sei Z = (P, Q) eine optimale Zeilenbasis zum LP (11) q der Index einer

verletzten Ungleichung, also s(Z)q < dq, und t = Dq^,

Gilt 0 so ist das LP (1.1) unzulässi Andernfall ist für

y

argmax ^ > 0,1 < i < n 1.25)

Z = (P', Q'), mit P' = P {p} U und Q{}ö { eine optimale

Zeilenbasis von (11) Ferner ilt

Z^l 1 26)

und

{Z = c(Z) + $ (Z ). 1.27)](https://image.slidesharecdn.com/soplex-tr-100422010730-phpapp02/85/Soplex-tr-37-320.jpg)

![22 KAPITEL 1. REVIDIFRTE SIMPLEX-ALGORITHMEN

Abbildung 1.5: Bei einem Schritt des dualen Simplex wird eine verletzte Ungleichung in die Basis

aufgenommen, wofür eine andere die Basis verlassen muß. Die beiden betroffenen Stützhyperebenen sind

gestrichelt dargestellt.

BEWEIS:

Fall 1 (t < 0):

Nach Satz 1 ist x(Z) die einzige Ecke von V(DP., dp). Demnach lassen sich gemäß Satz 3

und 2 alle x G V(DPl dp) als

n

x = x(Z) + ^ V j -Dp]ei

j=i

darstellen, wobei TI, . . . , r n > 0 gilt. Für alle x G V(Dp_, dp) gilt somit Dq,x = Dqx(Z) +

YH=iriDg.Dp}ei < dq + S r = i r ^ ^ dq, d.h. es gibt kein x G V(DR,dP), mit Dqx > dg.

Da also 0 = V(DP., dP) D {x : Dqx > dq} D V(D, d) folgt die Behauptung.

Fall 2 (t £ 0):

Wegen £p = [Dq,Dp^)p > 0 ist nach Satz 6 Z' eine Zeilenbasis mit dualen Variablen

yT(Z') = yT(Z) + $(t T - ej). Da j/(Z) > 0 und tp > 0 ist $ < 0. Für i G { 1 , . . . , n) {p}

gilt yi(Z') = yi(Z) + $*<. Falls ^ < 0 gilt somit j/^Z') > ^ ( Z ) > 0. Andernfalls gilt

wegen (1.25) y{{Z>) = Vi{Z) + $i< > ^ ( Z ) + ( - ^ ( Z ) ) / ^ • tt = 0. Ferner gilt yp(Z') =

yp(Z)—yp(Z)/tp-(tp—l) = yp(Z)/tp = —$ > 0, was die Optimalität von Z' zeigt. Schließlich

gilt nach (1.14) cTx(Z') = cTx(Z) + (dq-sq{Z))/tp-cTDp1ep = cTx(Z)-(sq(Z)-dq)/tp-yp =

cTx(Z) + <S>(sq(Z)-dq).](https://image.slidesharecdn.com/soplex-tr-100422010730-phpapp02/85/Soplex-tr-38-320.jpg)

![24 EL 1. R T E S I M P H M E

Anstelle die Vektore g und h in den ritten 4 und u aktualisieren, kann man

sie ebenso neu berechnen (dies wird auch z.B. bei partiellem Pricing in der Praxis durch-

geführt). Die gewählte Darstellung verdeutlicht jedoch besser die Anlichkeit von primalem

und dualem Algorithmus und ist bei vollständigem Pricing auch effizienter [16]. Alle nu-

merischen Berechnungen in den Schritten 2, 4 und 5 treten in beiden Algorithmen in glei

cher Weise auf Lediglich die Auswahl der Indizes p und q wurde vertauscht: Der primale

Algorithmus (in Zeilendarstellung) wählt beim Pricing zunächst einen Vektor, der die Ba

sismatrix verlassen soll, während der duale Algorithmus im Pricing einen Vektor auswählt

der in die Basis eintreten soll. Wir nennen daher Algorithmus auch den entfernenden

und Algorithmus 2 den einfüenden Algorithmus

Wie beim primalen Algorithmus ändert sich auch beim dualen der Zielfunktionswert

des Basislösungsvektors falls der Quotiententest einen von Null verschiedenen Wert liefert

Der Fall $ = 0 tritt auf wenn der neue und alte Lösungsvektor auf gleicher Höhe (in bezug

auf liegen (Z = 0 Solch einen P v o t S c h r i t t nennt man wieder deeneriert

1.2.2 Die Spaltenbasis

In diesem Abschnitt werden sowohl der duale als auch primale Simplex-Algorithmus erneut

vorgestellt, diesmal jedoch mit einer Spaltenbasis. Dies ist die Darstellung, wie man sie

üblicherweise in der Literatur findet. Sie wird hier als Umformulierung eines Spezialfalls

der zeilenweisen Darstellung der Basis vorgestellt

Sofern nichts weiteres gesagt wird, sei in diesem Abschnitt folgendes vorausgesetzt

m, n mit n, j , b Rm und A Rm hat vollen Rang etrachte das

LP

min

1.28)

ieses LP ist offenbar der umgeschriebene) Spezialfall eines LP der Form 1.1), mit

2m + n, = (I und (0, 6 nämlich

min

1.29)

b

b.

Für jede zulässige Zeilenbasis von (1.29) müssen die Ungleichungen {n + 1 , . . . , n + 2m} mit

leichheit erfüllt sein. Da A vollen Rang hat kann man zu jeder zulässigen Basislösung

eine zulässige Zeilenbasis Z (P,Q von (1.29) finden ei der alle Ungleichungen

> b zur asis gehören {ro + 1 , . . . , n + und (Z').](https://image.slidesharecdn.com/soplex-tr-100422010730-phpapp02/85/Soplex-tr-40-320.jpg)

![. D R U H M E

SATZ 1

Sei Z = (P,Q) eine zulässige Zeilenbasis von (129) mit Basislösungsvektor

(Z) ann gibt es eine zulässige Zeilenbasis Z (P von (129), mit

(Z (Z und P n + 1 , . . . , n +

BEWEIS:

Sei Z = (P,Q) eine zulsige Basis von 1.29) mit Lösungsvektor x(Z). Setze M {n +

1,.. .,n + m}, R{P) PnM und S(P MR(P), d.h. S(P) bezeichnet die Menge aller

Nichtbasisungleichungen von Ax > b. Gilt |<S(P = 0 so erfüllt Z bereits das Gewünschte

Andernfalls konstruieren wir eine Basis Z' = ( P , Q) mit x(Z') = x(Z), für die S(P)

S(P 1 gilt. Durch |S'(P)|fache Anwendung dieser Konstruktion erhäl n somit eine

sis die d ewünschte eistet

Betrachten wir für ein G S(P den Vektor x = AkD^. Wir wählen ein j G

{ l , . . . , n } , so d ß Pj ^ (P) und Xj ^ 0. Ein solches muß es geben denn sonst hätte

wegen A = ^2PdRrP) XA^ die Matri A nicht vollen Rang N c h Satz 6 ist Z = ( P , Q

mit P' {] U {k} und Q Q {k} U {P eine Zeilenbasis von (1.29) und wegen

sk{Z) = gi $,k) = 0 Somit ist nach (1.14) (Z) (Z' und Z' zuässig Offenbar

git S(P S(P) 1, as den Bewei beendet

•

Diese Satz erlaubt es sich bei de Suche n c h einer optimalen und zuässigen B a s vo

(1.29) auf solche Baen Z = (P, Q) zu bechränken, fü die P D M gilt. Die Zeilen {n +

1 , . . . ,n + m} können somit tet in de Bas verbleiben, w ä r e n d die Ungleichungen {n +

m + 1 , . . . , n + 2 } nie in die Bass gelangen (sie würde sonst ingular) und daher ignorier

werden können. Beides k n n man durch eine angepaßte Verwaltung der Indexvektoren

m d e l l i e e n bei der nur noch Zeilen { l , . . . , n } ausgetauscht weden Um die ffizient

duchfühen u können eignet ich die efinitin einer Saltenbas

EFINITION 5 (SPALTENBASIS)

Ein geordetes Paar S = (B,N) von exvetore B, C { l n }

Saltenbas (zum LP (1.28)) falls folgees glt:

1. Ui { l f j }

2. nN ®

= un

st nicht sinar

Di es a heißn Basisindizes ud d es a Nichtbasindi

Die Zeilenbass Z = (P Q) zu (1.29), mit P N U {n + 1 . n + } h

die zu S gehörende Zeilenbasis Die Vektoren x(S) = x(Z), (S) = s(Z) n

y{S y{Z) heißn der Basslösungsvektor, der Vektor der Schupfvarialen

resve der duale Vektor von S Eine Spaltenbasi S heiß lässig, wnn

T T

(S V b), und ptimal falls c > c x(S) r alle {A b)](https://image.slidesharecdn.com/soplex-tr-100422010730-phpapp02/85/Soplex-tr-41-320.jpg)

![. D RU 29

Schritt 5 Up

+Q

+ Q A

+ *(A

Schritt 6: Gee zu S c r i t t 1

ATZ 17 ( P R T I E L L E K E K T H E I T V LGITH

lgorthmu artet artell orre

EWEIS:

Bei Teminierung in Schitt folgt die Behauptung s Satz 15. Wegen Sa t in

chritt 6 B wiede eine as die wegen chitt 3 uch zulässig i t

Für die Unbeschränktheit des LP bei minieung in Schritt 3 betrachte das LP

29) und die u S gehörende Zeienbasi Z (P,Q). Wi identifieren nun die Größen

Agorithmu 3 mit denen a s Sat 9. N c h .33) gilt ]JN{Z) ^ — t(S) und somit

Z) 0. Fener gilt n c h ( fü den Vektor D^} und

A alb i t

Gi also in chitt , so folgt und d m i t n c h Sa die U n b e c h n k t h e i t

de LP

•

Algorithmus a t a t c h eine Umformuieung v n Algorithmus 1 in die N o t i -

n einer Spaltenbasis. Algorihmich e n t r i c h t Algorithmus 3 dem dualen Algorithmus 2:

Bei entsprechender Initialisieung aller reevanten Vektoren und Schranken unterscheidet

ich lediglich das T m i n a t i k i t e r i u m in chitt 1 gemäß de umgekehten Ungeichung

ichtung in (136

1.2.22 ualer Algorithmus

Wie uvor de imale A o r i t h m u w i d nun uch de duale fü eine altenbas umfor

muiet

LGORITHMUS 4 ( U A L E R I M P L E X - L G O R I T H M U S IN SPALTENDARSTELLUNG)

Sei S = B,N) eine opti Zeilenbas on (1.28)](https://image.slidesharecdn.com/soplex-tr-100422010730-phpapp02/85/Soplex-tr-45-320.jpg)

![TEL P L E H M E

lt f o e Zummehä

Is

L

Us

lz Ls

emna gilt für die Zeilebasis < gq < 7 d smit k ie f

Algoritmus 5 verwendet werden. esweiteren gilt g = _/jf > UQ UQ

bzw. g^ = f < LQ = I je ach F l l in Schritt 1 vo Algoritmus 6 omit

eignet sich q = Qz als eintretender I d e x von Algoritmus 5. Wenn wir och

—Agp1 Af zeigen, folgt mit den o e r e n Beziehungen, daß Algorithmus 5 in

Schritt 3 terminiert, da dies auch A l o r i t m u s 6 tut. Nach Satz 26 bedeuted

dies aber die Uzulässikeit des L s u d , da Zeilen- nd Spalten-LP äquivle

s i d , die B e u p t u n g

Es m ß also och A / ) = A% • [Ap] L~ev ^Q1 Ag ezei

werde Wir weisen die d z u ä q u i v l e t e Bezie

(^S (A i8i

ch zu erechn wir ch e e i e t e r ermuttio mit 150)

ÄQ2-nPl 0 Pl

-Tll

1

-nPi J -nP1 -n

-n 182

-n

Ferer ilt für {A~} ch 151

Q2_n q2_n _n _n Q2_n

183

Nu s i d zwei F l l e ZU nterscheide Flls fol -n

es -n mit ist (A

-n —n —n -nQi P , d. 8 wu wie

ll is f T

-n —n wo -n -n

T

' mit ilt T '

-n f Pl -n

Q2—n

-n d Bewe](https://image.slidesharecdn.com/soplex-tr-100422010730-phpapp02/85/Soplex-tr-66-320.jpg)

![3 TABITA DE PLEVERF

r Beweis zu all der T e m i n i o in Schritt 3 f r e S p a l t e a s i s basier

der Dualitätsbeziehung zwischen beiden sisdarstellungen und eide Alorithmustyen

Auch der Fall einer Zeilenasis hätte so bewiese werden können azu würde m die

Bedeutung von Zeilen- d Spalten-LP vertauschn, und es müßte n c h der F l l 6 = 9o

ausgeschlossen werden. er direkte Beweis schie da einfacher, zum hnliche Beweise

ereits vorestellt wurde

1. S t a b i t ä t des Siplex-Verfahrens

Die A u f e umerischer Agorithmen ist die Berechnung e i e r Abbildug W1 —• Rm >

Bei der Implementierung auf realen Comutern ist man stets mit dem P r o l e m edlicher

Genauigkeit konfrontiert Da ein Rechner nur ein Gitter von endlich viele ahlenwerte

darstellen kann wird jede reelle Z l durch die nächstliegende Z a l i diesem Gitter appro

ximiert. Also repräsentiert jede im Comuter dargestellte Gleitkommazah ei Intervll und

ist somit a priori f e h l e r f t e t er reltive Feler eutiger 6BitGleitkommaaritmetik

liegt in der Größeord vo ~16

Ein numerischer Algorithmus e s t e t us einer Reihe von R e c h o p e r a t i o e bei de

sich Fehler akkumuliere könne Dies kann so ravierende Ausmaße n n e m e , da as

berechnete Resultat keine v e r n ü f t i e Aussage ü e r die zu lösende A u f b e mehr erlaubt

Auch der Simlex-Algorithmus leibt von diesem Problem ncht verschont. Desha wird

er i diesem chnitt uf sei numerisch chften h untersucht

In de bschnitten 1.3.1 und 1.3.2 werden die Begriffe der Kondition eines numerischen

roblems d der Stabilität eines numerischen Algorithmus e i g e f ü r t . Wir orientiere

ns dabei an den Darstellunge in [34] und 39]. Anschließed wird in schnitt 13.3 die

telle im implex-Algorithmus aufezeigt, die umerische Schwierigkeite sich birgt, un

worauf zu achte ist um eine I s t b i l i t ä t zu umehen. Schließlich werde in Abchnitt 1.3.4

drei verschiede ilisieru vorestellt u d diskutiert die für lex imlementiert

wurde

1.3. Kondition

Ein numerisches Problem r = f(e) esteht dari ei Eingabevektor e £ l ™ uf einen Re

m

sultatvektor 6 E abzubilde. Nun kann der Egabevektor auf keiem Comuter exakt

dargestellt sodern nur durch Gleitkommazahle pproximiert werde. Also reräsentiert

jeder Gleitkommavektor Wirklichkeit e i e U m g E von Eingabevektore, die Feh-

lermenge von e Der o m u t e r ist icht in der Lage, zwisch verschiede Elemente

von zu unterscheide. aher ist es sinnvoll zu studieren wie E durch bildet wird.

ies wird vo dem Beriff der Kondition e i e s Prolems eschrie](https://image.slidesharecdn.com/soplex-tr-100422010730-phpapp02/85/Soplex-tr-67-320.jpg)

![TEL P L E H M E

D E I T O N 10 ( K O N D I T O N )

Sei ein numerisches roblem, l e e von und

-x<

f( D ist it der Bezeichnung [X sux,eX ?j für

NI

j§ 18

die Kondition des Problems f. Ist K ~ 1, so nennt ma das roblem ut kon-

ditioniert für K > nent ma es chlecht k o d i t i o i e r t nd für =

nsachgem gestellt

Ferner definiere die K d i t i o eier r e u l r e atrix al

(A -i 8

Die K o i t i o n eines numerisch Prolems hängt somit nicht vo em e w l t e Al

ritmus sodern ist e i e E s c h f t des Problems s e l s t

Wir betrachten die Kondition der Lösung vo linaren G l e i c h s s y s t e m e , d diese

für S i m l e x - A l o r i t m e vo z e t r l e r Bedeutu ist Schritte 2 u

SATZ 28 (KONDITIO E I E R REGULÄREN MATRIX)

Für n G N sei b x, b, Ab M A, Ä, AA RnXn und A ncht singular

derart daß A = A + AA b = b + Ab, und x = x + Ax, sowie Ax = b und

Ax b. Die Größen mit bezeichnen fehlerbehaftete Größen und die Werte A

den Fehler Ferner sei e 4 ^ nd e(A % ^ . Fall (A) < ist

gilt

)) 186

T3ÄÄJ

BEWEIS:

Nach V o r u s s e t z u g gilt AA + d somit = ||A _1 ( +

AAx - AAA) A'1]] • A WA^W • AA • x + WA'1]] • AA • Ax We

A"1!! • lAA|| = ü^- 1 !! • lUll • | | A A | A | | = «(A) (A) < ilt (1 - K{A) e(A))Aa

1

A- !! • lA& + « ) c(A) • x D u s fol

( = | | / | |

1-(A (A |A|| • ||x||

<A

MA ))

1- {A {A

nr n man f r [X] auch e n a Maß wä Ma](https://image.slidesharecdn.com/soplex-tr-100422010730-phpapp02/85/Soplex-tr-68-320.jpg)

![3 TABITA DE PLEVERF

tz 28 g t e i e A h ä t z u n g für den ehler des Resultats e{x durc den ler der E

bedaten e(A + e(b). Insbesodere ist für gut konditioierte Matrize mit (A) ~ 1 u

e(A) < 1, die Matrixkondition ) eine gute Approximation für die ditio der ösung

des lineare Gleichungssystems Ax b denn nn ist e( < (A) (e(A) )). D die

ondition K(A) ncht von der rechten Seite b gt, repsentiert sie die Konditio für

lle l i r e Gleichgssysteme mit der Matri d e i e r e l i e e n rechten Seite

1.3.2 Stabilität

Bei der plementierug e i e s Algoritmus zur Lösung e i e s numerischen Problems, wer

den im llemeinen Zwischenresultate berechnet, ei d e e n zusätzliche Feler auftrete

könn Das bedeutet, d ß eine Imlementierung eines Alorithmus nicht e x k t die Abbil

dung / berechnet sodern eine etwas andere Abbildung / . Diese bildet nun e auf f = f(e)

statt uf r f(e a . Wie dieser Feler zu ewerte ist, wird durch die Stabilität e i e s

Aloritmus eschrien

Es ibt zwei A ä t z e zur Behandlu der bilität vo A l g o r i t m e , die Vorwärts

d die Rückwärtsanalyse Wir beschnken uns ier uf den zweite Ansatz, der für die

tabilitätsanlyse der LU-Faktorisierung zur Lösung liearer Gleichussysteme verwendet

wird. ie Grundidee dabei ist, de Feler des Alorithmus / durch einen erweiterten Fehler

der Eigabedate zu modellieren. Dabei repräsentiert e i e Implementierung des Algorith-

mus eine ganze Fmilie F vo b b i l d u n g , mit E F s o s t wäre die lementieru

nicht korrekt

D E F I I T I O N 11 ( S T A B I I T Ä T )

Sei f(e) ein numerisches roblem nd eine Implementierung zur Lösung von

f. etze E = {e : f( f( F} eiß s t i l , falls [ «

und s t i l , falls [E E]

1.3.3 nalyse der Simplex-Algorithme

a bei der Defiitio e i e r B s i s nur azzahli Werte auftrete ist die ndition des ro

blems "Löse ein P mit dem i m l e x - A l o r i t m u s " gerade die Kondition des Gleichung

systems der optimalen, zulässi Basis3. ie numerisch stabile Lösung von dünnbesetzten

l i r e n Gleichungssystemen — und B s i s m t r i z e n s i d tyischerweise d n n e s e t z t wird

chnitt 1 7 se behadelt.

3

Dieses numerische Problem ist nicht äquivalent zu dem Problem "Löse ein LP" etwa mit einem

Innere-Punkte Verfahren Dies liegt daran daß der Simplex-Algorithmus stets noch andere Resultate

liefert, nämlich die Basi und alle damit usammenhängenden Vektoren auch wenn man sich n r den

ngsvektor und den Zielfunktionswert asgeben läßt](https://image.slidesharecdn.com/soplex-tr-100422010730-phpapp02/85/Soplex-tr-69-320.jpg)

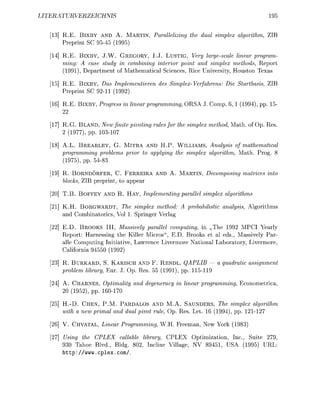

![1.3. STABILITAT DES SIMPLEX-VERFAHRENS 57

Abbildung 1.6: Stabilisierungen des Quotiententests. Das mathematische Verfahren nach (1.22) würde

die neue Basislösung auf den Kreis positionieren. Aufgrund des geringen Winkels der Stützhyperebenen an

diesem Schnittpunkt ist die zugehörige Basis jedoch schlecht konditioniert. Zur Stabilisierung werden daher

die um einen Betrag ö verschobenen Schranken betrachtet, die gepunktet und mit dunklerer Schraffur dar-

gestellt sind. Die Stabilisierung gemäß Ansatz 1 liefert den mit der Raute gekennzeichneten Schnittpunkt

als neue Basislösung, da in diesem die zugehörige verschobene Schranke als erste erreicht wird. Dieser

Schnittpunkt ist durch das Kreuz gekennzeichnet. Die Ansätze 2 und 3 wählen unter allen Schnittpunkten,

die vor dem Kreuz liegen, den numerisch stabilsten aus. Dieser ist durch das Dreieck markiert.

Dieses Verfahren ist offenbar das "stabilste", das mit der Idee der Toleranz S möglich

ist. Dennoch birgt auch dieses Verfahren dieselben Probleme wie das zuvor beschriebene.

Varianten des Quotiententests von Harris werden z.B. in MPSX und CPLEX eingesetzt

[12, 13].

3. Ansatz (SoPlex Quotiententest)

Es folgt eine Beschreibung des für SoPlex standardmäßig empfohlenen Verfahrens. Wie das

von Harris benötigt es auch zwei Phasen, wovon die zweite Phase mit der von Harris über-

einstimmt. Zur Bestimmung von Qmax wird jedoch erlaubt, daß sich die Schrankenüber-

schreitung um S verschärft. Setze also

c _ j 5 , falls Si > di

%

Si — S sonst.

Damit wird Qmax bestimmt gemäß

„ f di — Si — 5i 1

Qmax = max t — : As» < 0 ^ .

Anschließend wird q gemäß (1.90) bestimmt.](https://image.slidesharecdn.com/soplex-tr-100422010730-phpapp02/85/Soplex-tr-73-320.jpg)

![DI DE P L E T H

direk agegeben weden kann. A l i e d wird a s d g eine z i g e Bis

für das Ausgangs-LP konstruiert

In Lehrbchern findet man meistens einfache Varianten des P a s e - 1 - L s die zwar eine

numerisch stabile Imlementierung erlauben, jedoch eine hoh Itertionsza edingen. er

einfachste Fall eines h a s e r o b l e m zu (191) ist das L

min

st

(193)

o

0.

Auch hier ist die Basis aus den Varialen s zulässig. Gilt für die optimale Basis-Lösung

von (193) s ^ 0, so ist das Ausgangs-LP unzulässig. Andernfalls ist die optimale Basis

von (193) eine zulässige Basis des zu (191) quivalenten L

min

st

(1

0.

Der Effizienznacteil dieses Verfahrens ist, daß einmal die Basis komplett ausget

werden muß, damit alle "künstlichen" Variablen s aus der Basis entfernt werden.

Das composite Simplex-Verfahren arbeitet deshalb direkt auf den Varialen des

AusgangsLPs und modifiziert das LP dynamisch zur jeweils aktuellen Basis 00]. ei

S = {B,N) eine eliebige Basis von (191) Dann definiert man das zugehörige ase

r o l e m als

min c{BxB

BxB AN

(195

xB

wobei c(B)i = —xBi für xBi < 0 und c(B)i = sonst ist. Dieses Verfahren h t sich ls ef

zient erwiesen und kommt in kommerziellen Imlementierungen zum Einsatz (zB. CPLEX

[16]). Trotzdem erscheint es noch verbesserungsbedürftig, denn dieses hase-1-Problem ist

ausschließlich mit Blic auf das Erreichen der Zulässigkeit konstruiert ercksichtigt aber

nicht die Zielfunktion.

Bei SoPlex wird daher einen andere Strategie verfolgt, die auch in der Phase-1 die Ziel

funktion so gut wie möglich mitberücksichtigt. Außerdem werden wieder keine künstlichen

Varialen dem LP hinzugefügt. Es sei (B,N) eine beliebige Basis von (191) Als

a s e - P r o l e m wird das L

min xB

BxB AN

(196)

xB](https://image.slidesharecdn.com/soplex-tr-100422010730-phpapp02/85/Soplex-tr-75-320.jpg)

![TEL IDI PLEITHME

v e r w e n d , wobe k = xBi ür xBi < 0 u d k = 0 s o s t ist ieses LP behält s m i t s v i e

von der truktur des AusgangsLPs bei, wie es die Basis S zuläßt. Außerdem wird die

Schrank / im Laufe der Phase-1 weiter hochgesetzt, sofern es die jeweilige Basis zuläßt

adurch kommt es nicht selten vor, daß ein LP ereits nach der Phase 1 gelöst ist.

Per Konstruktion ist S für das LP (196) zulässig, so daß der primale Simlex gestartet

werden kann. Terminiert er mit einer Optimallösung von (1.96) so ist die optimale Basis

für (1.91) immer noch dual zulässig, und es kann der duale Simplex gestartet werden.

Andernfalls ist mit (1.96) auch das Ausgangs-LP unbeschränkt. Entsprechend kann auch

ein Pse-1-Problem durch Manipulation der Zielfunktion konstruiert werden, für das die

asis 5 dual zulässig ist. n diesem Fall wird zunchst der duale implex verwendet

Eine Implementierung für allgemeine Basen gemäß Abschnitt 1.2 gestaltet sich be

sonders einfach. Es muß lediglich eine andere Initialisierung der S c h n k e n erfolgen und

zwischen eiden Algorithmustyen umgeschaltet werden.

1.5 reiseln u n d dessen V e r m e i d u n

Wenn der primale oder duale Algorithmus eine unendliche Folge degenerierter Pivot

Schritte durchführt, spricht man vom Kreiseln. Das ist die einzige öglichkeit dafür, daß

ein SimplexAlgorithmus nicht terminiert. ies sieht man wie folgt: Es gibt maximal Q)

verschiedene Basen zum LP (1.1). Bei jedem nicht degenerierten PivotSchritt ändert sich

der Zielfunktionswert des Basislösungsvektors streng monoton fallend für den primalen

und streng monoton steigend für den dualen Algorithmus emnach kann die alte Basis

nie wieder angenommen werden, so daß maximal ^) — 1 nicht degenerierte PivotSchritte

öglich sind. amit ist folgender Satz bewiesen

SATZ 30

ei Simpex-Algorithmus ht termiiert, kreiselt er

ie Vermeidung des Kreiseins ist somit eine wichtige Anforderung für die Brauchbarkeit

von Simplex-Algorithmen. In [26] wird das Kreiseln zwar als ein rares Phänomen beschrie

ben, das in den meisten Implementierungen aufgrund numerischer Feler nicht auftrete und

somit nicht berücksichtigt zu werden brauche Heute werden Simplex-Algorithmen jedoch

vielfach für kombinatorische Optimierungsroleme eingesetzt, ei denen die Nebenedin

gungsmatrix oft nur aus Werten 0, 1 und besteht und das LP sowohl primal als auch

dual degeneriert ist Die dabei auftretenden Basismatrizen sind häufig so gut konditioniert

daß die egeneriertheit auch numerisch erhalten l e i t Desalb kann das Kreiselrolem

nicht m e r unercksichtigt leiben.

Es gibt eine R e i e theoretischer Ansätze [17, 99, 9 103], die ü e r pezielle Pricing und

Quotiententest verfahren ein Kreiseln ausschließen. In praktischen Implementierungen wer-

den sie jedoch kaum eingesetzt. Ein Grund dafür ist daß eine strikte Verwendung solcher](https://image.slidesharecdn.com/soplex-tr-100422010730-phpapp02/85/Soplex-tr-76-320.jpg)

![1.5. KREISELN U DESSE VERMEIDU

Pivot-Verfaren in de Regel zu wesentlich mehr Iteratioen führt. Dies kann z B . d d u r c

umangen werden, daß, solange ein Fortschritt bei der Lösung erzielt wird, eine besse

re Pivo-Strategie verwendet und erst, wenn mehrere degenerierte Schritte nacheinander

a u s g e f r t worden sind, zeitweise auf eine Kreiselvermeidungsstrtegie umgeschaltet wird

Ein anderer Grund, theoretische Kreiselvermeidungsverfaren nicht in praktischen Im

plementierungen einzuseztzen, ist, daß sie bei numerisch stabilen Implementierung nich

mehr anwendbar sind. Sie basieren meist daauf, daß die Basislösung während des Krei

seins unverändert bleibt Wie in Abschnitt 1.3 beschrieben wurde, trifft diese Voraussetzung

bei numerisch stabilen Implementierungen auch im degenerierten Fall nicht immer zu, da

eine leichte nzulässigkeit toleriert wird. Dadurch ist es möglich, daß ein "numerisches

Kreiseln" mit leicht variierenden Lösungsvektoren und schwankendem Zielfunktionswert

entsteht. Z.B. kann bei Algorithmus 1 eine Verschlechterung des Zielfunktionswertes auf

treten, wenn eine Variable di — 5 < Si < di die Basis verläßt. Dies kann durch sog Shifting

verindert werden, ei dem die Schrank di z.B. auf s erasetzt wird.

as Shifting bildet die Grundlage für die Kreiselvermeidung von SoPlex, die nun anhand

von Algoritmus 1 eschrieben werden soll. Sie ähnelt der in [12] vorgeschlagenen M e t o d e

die bei MPSX zum Einsatz kam. Nach maxcycle Pivot-Schrtten ohne Fotschritt

beim nächsten PivotSchritt enen Fotschritt ezwungen, ndem fü alle i, mit s* di + 5

und Asi < 0, d e Schranke di auf di « s and(1005, 10005) gesiftet wid. i ist

nd(1005, 10005) ein zufälli aus de Intevall (100,10005) gewälter Wert. Für den

aameter maxcycle hat sch We n de rößenodung 1 e w h r (vgl A c h t t

2.8).

er Zwek de zufälligen W a l von di ist, d e e g e n e e t auch zukünftige

PivotSchrtte aufzubechen. Andee Verfhren p e t u e n deshalb das gesamte LP, even

tuell soga gleich zu Beginn. ies eschent jedoch e ungünstig, da so meist m h r

SimplexIteationen notwendig weden als ohne P t u b a t o n : Oft at man nämlich Gl

und der SimplexAlgorithmus v e ä ß t ene degeneriete cke o n e weiteres Zutun. Beim

g e s t t e n LP ist eine solche Ecke n eine Sch von Eken aufgebrochen, die der Simplex

Algoithmus nun einzeln travesieen muß. Entsprechend eicht es völli aus, wenn de

SimlexAlgoithmus eie optimale Basis findet im g e s t t e n Fall st des zwangsläufig

auch e enzge und somit schwe zu finden.

Handelt es sich m e P h a s e 1 b l e , so ist das Shiften des LPs u n p r o l e m a t c h

handelt es sch doch n e n schon um ein LP mit v e ä n d e t e n Schranken. Andefalls muß

nach T e m i n i u n g mit de jeweils dualen Algoritmus fotgefahren weden. es w d so

lange t e t s e n A l g o m u s au de unverändeten L t e m i n i t .

Es g b t keinen Terminationsbeweis fü ine solche Kreiselvemeidungsstatege. In de

P x i s sind jedoch noch kene Fälle aufgeteten, denen de A l g o t m u s ad nfintum

zwschen den asen u s c h a l t e t , wel das LP imm weder verändet wude. es kann

dadurch wete chwet weden, ndem man d e Anza maxcycle d e g e n e t e Pivot](https://image.slidesharecdn.com/soplex-tr-100422010730-phpapp02/85/Soplex-tr-77-320.jpg)

![62 TEL 1. REIDIER PLEORITHME

Schrtte vo de Stufte jede chalte chsetzt.

Ein weiter Vorteil von Kreiselvereidungsstategen mittels Shifng gegen dem

Umschalten auf theoretisch S t a t e g e n st, daß d gewählte ing-Strateg beibehalten

weden kann. Außede d en s t k e odulater Seentwu öglcht.

N e e n den Arbiten zu eoetischen Kreiselvermeidung g b t es kau Liteatur übe

p r a k t a b l e Strategien. I b e s c h r e n Gll Murray, Sauders und W r g t eine Strate

e, bei der de T o l e r a n z a r a e t e r 5 beim Harrs-Quotiententest mi jedem PivotSchrtt

hochgesetzt w d . Wenn anscheßend in de zweten ase des Quotententests kein Fort

schritt e i e l t wid, siften s e die Schranke um den aktuellen , und da 5 öße st

als n de vorigen I t e a t o n , w d so e n Fotschrtt ezwungen.

Zwei Nachtele sind b i diesem Vefahren gegen dem zuvor beschrbenen zu ver

zechnen. Zum enen wchst de Toleanzparamete S mit jede Iteation. es entsprcht

ab einer glechzeitigen R e l a r u n g aer Schranken, auch wenn des icht notwendg wäre.

nsbesondee st nach T e m i u n g d e Lösung bis auf das geade aktuelle zulässig, und

n aller Regel muß ene w e t e e P a s e angeschlossen werden. Zum anderen hren degene

rierte Pivot-Schritte a. w e t e e V a b l e n n die um 5 relaxierte Schranke heran. Dadurch

schränkt man die W a l f r e i e i t b i m n u m e c h e n Quotententest wiede unnötig ein. Ins

besondee ist die Erhöhung von essentiell fü ine numerisch stabile Impleentierung. I

57] wird scheßlich eine Gegeneispiel angegeben, das diese K r e i s e l v e r d u n g nch

funktioniert. Di Konstukton eines solchen Gegenbispiels s c h t e t jedoch r r n d o m i

te Ansätze w e s r S l e x zugundegelegt wuden.

1.6 ricg-Straten

Be de Aufstellung der S i m l e A l g o i m e n wude im jeweiligen Pricing-Schritt ledg-

ch e Bedingung fü w ä b a r e ndizes genannt. S m i t snd vele Varianten von Algoith-

en öglch, die sch in der konketen Auswal, der sog. Pricng-Strategie, unterscheiden.

i ist geade sie von entschidende Bedeutung ür die Anzahl von Iteratonen und

somi für di Effizenz von i m p l e x A l g o r e n . Es ist jedoch keine Strateg ekannt

für alle L P P o l e e a ffizentesten a t e t . eshal weden nun ene e von

ng-Srategen vogestellt.

Der nfchheit h a l e r gehen w dazu au das L 1.1 und die Algorithmen 1 und

zurück. Die Eweiterung au e A l g o e n mit allgemener Basisdastellung ist prblem

los öglich, fordet jedoch ine k o t e e Notaton e d e zugundelegenden deen

nu v e c h l e n w r d e .](https://image.slidesharecdn.com/soplex-tr-100422010730-phpapp02/85/Soplex-tr-78-320.jpg)

![1.6. R I C T E G I E N

Abbildung 1.7: Das steepest-edge-Pricing rhindert, daß aufgrund unterschiedlicher Normierungen de

Richtungsvektoren A#W eine weniger steile Richtung gewählt wird. Diese Situation ist in der Abbildung

dargestellt. Obwohl Ax^ einen geringeren inkel zum Zielfunktionsvektor —c aufweist als AxW s m c i di e

zugehörigen reduzierten Kosten höher

e B e c h u g de erte pi ach (1.97) e d e t e e i n h h e R e c h n a w a d .

jeden W r t müßte ein l i a r e s Glechungssystem zur Bestimmng n AxW gelöst un

darüberhnaus ein Skaarprodut b c h n e t weden. Aus dese Grund galt d s steepest

edge P n g ang Zet als zu aufwendg obwol bekannt war daß es zu e e rheblche

Redu de ahl der votSchritte fhren kann st als Goldfarb u Red U p a t e

Foel die Göße pi m u l t e n , wude es zu e rakkable V e f a h r n [ 7]

Es weden nu die UpdateFomel pi f de i m l e n Simplex in Z l e d a r s t e l l u n g

aufgestellt. Dese Darstellung ubt e essees e o e t c h e s Vestän ls de n [2]

beschrttee W

ei Z Q) d ass nach e i m Pvot-Schrtt mi Indzes p u d q. Nach (1.1

st die neue B p = VP

> mit V = I epqD^1 — £) u nach (1.89) lt

V-1 = I e

*u p x^ Z ann glt mi 'x® ^

T

= p}:

1

'j( ~ -

-]fß

x® f • x^ i

p] e ££ f x^ sost.](https://image.slidesharecdn.com/soplex-tr-100422010730-phpapp02/85/Soplex-tr-81-320.jpg)

![1.6. RICTEGIEN

1.6. rici

Beim Devex cing handelt es sich u eine Appoximat des steepest-ede P r n g

be de ei ichst inge Rechnaufwand anällt, indem Multplkato pi ch

exakt bestimm w e d e . Es wude P. Harr rgeschag ]

ü de e f ü g d e A l m u s anstelle 1.1 f o l d e Upate

Foel wedet5

fH + ( ! £ ) W 1-1

ür i q kann weite 1.12) w e d e t weden. Man erhält (1.13) durch enfaches W g -

sse des Smmanden n (1.101 de ösung des zusätzlche G l e c h n g s s y s t e s u

e B e c h n u n g der Skalarpodute e o d e r n wüde. E n t s p c h d e r h l t an de

r n d e n Simplex r i ^ p d e U p t e F o e l

Pi + (j 1-1

wobi f r i = ede 1.99 w e d e t wid.

Die U p d t e F o e l n des Devex P r i n g s führ zu ß die Gewichte pi stetig an-

wachsen. m dieses Wachstum zu begrenzen, wede sie auf 1 zuckgesetzt, sobald e

Gewcht e n Schwellwe ü b e c h r t e t . Es hat sch n Schwellwe 06 bewährt.

1.6.7 igh ricin

W e das steepestede ode Devex Picing utzt a c h da weighted P c i n g r ä f e r z p a -

r a e t e pi fü e PivotAuswah m G e g s a t z zu de erstgnannten werde iese s t c h

beim art des i m p l e x A l g m u s festgesetzt u ncht b jeder SimplexItera ak-

t u l i s t . olch Verfahren eignet sich, wenn man über ne gute H e u s t i k v e r g

die I n f m a o e zu lieern kann, welche Bedingnge bei de optimlen Lösung mi

Gleichht efüllt se wird. Es ö n n n ber a c h Gewchte r allgeeine Ps onstuie

weden, e des Abschntt 1.8. ch Kost r S a r t b s beschrebe

d.

arris spglic

i = j , [^-zM q

vorgeschlagen. Diese Approximation e r s c i n je als (11 sic st

mit SoPlex als die schlechtere erwiesen.](https://image.slidesharecdn.com/soplex-tr-100422010730-phpapp02/85/Soplex-tr-83-320.jpg)

![17. LÖSU LINEARER GLEICHUNGSSYSTEME MIT DER BASISMATRIX 69

R e p r ä s t a t i o n d r N N s e i n r M i x ab. eute f g t e l l t e LPs s f a t imme nn

etzt nabängig von der R e c h c h i t e t u r

Es g t zwei Anätze zur u m e c h e n ösung von linearn Gleichungssystemen n i c h

direkte u d iterativ ö . Wie i Abschitt 7 aufgezeit wird, rscheien letzte

den rste Blick vieverspreched scheiden jedoch aus da ihre Konvergen nicht g n ü g n d

abgsichert werden kann. Dehalb werden bei Impemetierung des Simpex-Algorithmus

direkte M e t h d e eingeetzt. ie werden in den A b c h i t t e n 1 . 2 und 17. diskutiet. In

letzteem wird auch die für SoPlex impementierte ersion ein LU-erlegung de Ba-

ix beschiebn. In A b c h i t t 17.4 w i d die Lsung von Gleichngssystemen ei

ggebene L U - e r l g u n g de ix b e c h i e b n . Aus Effiziengrnde t e angezeigt

eine L U - Z r l e n g der B s i s i x für ein lge von P i v o t c h i t t e tzen. Zwei

Methden, die t n , wede chitt 5 votell

1.7 rative Lös

Itertive Löse für l e a r e eichungssysteme bess i t e t i v (daher der N m e eine

Approximation de ö s u n g s v r s bis die ewünschte Gnauigkeit erreicht wird. In jede

I t e t i o n geht meist ur die Matrix der Vektor der rechten eite d die ktulle Appr

ximtion de Lösungsvektrs ein, wdurch der Speicheed im G a t z z d i k t e

L n für d n n b e t z t e M a i z e n b c h ä n k t bleib

ür die Impementierung von implex-Agorithmen erscheint ein weiteer P u n t vor-

teihaft. G i t es etwa beim duaen Simplex noch „ehr sark" vrletzte Ungeichungen,

erknnt man diee uch wenn die Genaukeit des k t u l l n B s l ö s u n g k t o r s noch

ng ist. Mit Fotschreiten der Lösung des LPs kann die G n a k e i t der L ö s u n g s k

n angepaßt werden. Dabei kann de Lösungsvektor der vor implex-Iteration ls

t w e t für die i t e t i v e Lösung de Geichngssystems für den neu asslsungsk

to tzt weden. iete iteative L e ssere Ansätze zur llelierung als

die wärts- u d rtssubstittion, da ihnen w e n i r Sequetialität i h ä n t ist

[83 8, 66]. G r u d genu also, die A n w e b a r k e i t i t e t i e r Geichungssystemsl für

den impex-Agoithmus u untersuchen. Dazu be w r ein kurze E i n f r u n g die

M t e i e ür ei fassde blick sei z a f [ 4 6] wien.

E gibt zwei Anätze für iteativ eichngssystem Klssche tetionfa

b a i e n af e i r Fixpktitetion

xfc = Gxk + gmit ~lB ~lb (110

wobei Q~l ein (regulär Appoximation von B~l ist. Offenba nach Konv x

1

Xfc Xk die Lösung des Gleichngssystem denn aus x = Gx + g = ~ (B folg

Bx = b. Verschiedene I t e r a t i o n s v f a e n nterscheide ich in der W von Q chon

beim einfache F l l symmetrche positiv d e i t e r M i z e n B k o n v r g i e n d e r t i g e

tetionfa j e d c h nur falls der S p e k t l r d i u s mit cheide ie](https://image.slidesharecdn.com/soplex-tr-100422010730-phpapp02/85/Soplex-tr-85-320.jpg)

![KATEL 1. REIERTE MPLEX-ALGORITHMEN

für die A n w e g n SimplexAlgoithme us d e n für l l m e e B i z

kei Konv g a a n t i e t weden. 7

Modeere teationsfahr nd Varianten des V f a n s der konjgierten G d i e

ten. Ihr V t e i l i t , aß für b e l i e g e s y m m e t c h p o i t i definite Matize die Konvrgen

nachgewie weden kann. Die o n v c h w i d i k e i t hängt j e d c h von der Kondi

tion de ix B ab

xk xk)< ^3ß X o x 0 ) (110

lJ

Erweiterungen von Konugierte-Gdienten-Methoden a s y m m e t c h e M i z e n ba

i e n a der S y m m e t i e r u n g de Gleichngssystem

= B (110

Die rschechtet j e d c h die K o n v g c h w i d i k e i t , denn

E n e erbessrung der Konvegenzgeschwindikeit von K o n i e t e n - G r a d i e n t e M e

t h d e n beteht in der sog. Vorkonditionierung. D w i d die M r i x B von beiden Sei

ten mit e i r Vorkonditionierungsmatrix C zw ultiplizie Die Matrix C w i d s

ewählt, d ß mit ih die Geichungssysteme direkt ösbar s , und die Kondition von

BCT klein t Für Gleichungssysteme die aufgrud i h r r Hrkunft (etw der Lösung

partieller Dierentialgleichungn) eine vohersagbare Struktur a b n , önn wirkung

volle poblempezifische rkonditionie n t w i c t weden.

Für den satz in e i e m llgemeinen Simpex-Agoithmus bed es jedoch eines

rläßlichen allemeingültig orkonditioniers Die ntsäche r einer Approxi

mation ei dirkte L ö r s amit llte de axi ew ein vollständi

dite de ten.

Auch wenn iterative Löse für Simpex-Algoithmen ausscheiden, könnten sie den-

noch für die Lineare Pogammierung von Nutzen sein. Der H a p t f w a n d innre-Punkte

V f a h e n beteht i de ösung von Gleichngssystemen mit de M i x ATA, wobei A die

N e b e n b e d i n g u n g t i x ezeichet Diee ist nbar symmetrisch und e bleibt zu unte

suchen, ob damit nügend Sruktur vorhanden i m ein geeigneten Vorkonditionierer

d e f i i e n . Ein mögicher Vorteil bei de Anwendung iteratier öser läge i de sse

n P l l e l i s i e b a r k e i t und in der öglichkeit, inexate Methoen zu r e s i e n , d die

G n a u k e i t de Lösung von Gleichngssysteme de k t l l fodess i n n l

de n n P t e f a a n s s n .

7

Es gibt sogar eine Publikation [37], die eine Implementierung des Simplex-Algorithmus mit dem Gauß

Seidel-Verfahrens (Q ist die obere Dreiecksmatrix von B) beschreibt Allerdings ist diese Implementierung

eher ein Kuriosum als ein zuverlässiger Algorithmus](https://image.slidesharecdn.com/soplex-tr-100422010730-phpapp02/85/Soplex-tr-86-320.jpg)

![17. LÖSUNG LINEARER GLEICHUNGSSYSTEME MIT DER BASISMATRIX

1.7.2 Diekte Metoden

Bei d i t e n Lösungsvrfahn wird die M i x ein P r u k t von Matizen trans-

formiert, mit denen Geichungssysteme dire st wede können. Beim Simpex-

gorithmen k m m e n ei zwei Typen von Mtrizen zum Einatz, Rang-1Updte

M r i z e und Deiecksmtrizen. Andee d i t e Lösungmethden, wie z.B mit Gi

R o t i o n n ode HousehdeReflexionen [4] werden trotz bssere m e r c h e Egen

schaften fgrund ihres ö h e n R e c h e n a a n d s u d der schechte A u s t z n g de

B e e t z n g r u k u r icht wedet

RangUpdteMize ab die

T

ei(ri (110

u d wurden b e i t s für de B a s u s c h (vgl. (1 e i n g e h r t . Die Invrse solcher tri

zen kann nach (189) d i r e t anggeben werden, aß sie ich zur Kontruktion diekte

sungfa e i g n . Die ksseitige Multipikation e i e r Matrix B mit V e r g i t die

Matrix = B ei(rT die us urch A u s u s c h der lten Zeie mit j1B

sultie

H i s r i s c h wurde für den idiete Simplex-Agoithmus z c h s t die og. Produkt

fom der Invrsen (PFI) erwendet 5 63] Bei de PF w i d die h e i t a t i x durch d

a x i m l nfache P u k von R a n g U p d a t e M i z e i die M i x anfomiet

Vn

Stimmen ei e i g e Zeilen von B mit de Einheitmatix überein, so bedar ntspe-

chend wen Matrixmultiplikationn. Die eihenfoge der u s e t u s c h t e n Zeile t dabei

tcheide für die m e c h e bilitä d de p e i c h e c h de P I

Beim Simplex-Algoithmus werde die Vektoren r/ ohnehin für die Update echnet

o daß die PFI als die für Simplex-Algoithmen naürliche Wahl r s c h e i . Im fe de

Simplex-Algoithmus immt j e d c h die numeische Stabilität der I ab und de enöti

te S p e i c h e r a a n d zu Deshalb m ß die P I von eit z Zeit mit ei ss

Pivoteihenfog e c h e t weden.

Untersuchunge aben gezei aß die PFI a. e i n öß Speicherbedf afweist

ls die im nächsten Abschitt dargestellte LU-Zerlegung 11 a der Speicheredaf et

wa der Berechungzeit zur Lösung von Gleichungssysteme enspicht, v w e n d e n heutig

mplementierung des Simpex-Algorithmus die L U - e r l e g n g de B a m t r i x Dennoch

blei ch die PF weitehin inteessant denn R a n g U p d t e M i z e wede m i t n t e

für uschchitte w e d e t vg b c h i t t 5)](https://image.slidesharecdn.com/soplex-tr-100422010730-phpapp02/85/Soplex-tr-87-320.jpg)

![KATEL 1. REIERTE MPLEALGITHME

obei e die Maschinenauigkeit eichnet 39] Somit muß da c h m de Maix

emente wähend de l i m i n a t i z e s s s k n t l l i e t weden

Bei der Pivot-Auswah ietet ich eine Mglichkeit das Wachstum de K o z i e n t e n

während des iminationspozesses zu teuern. Offenbar f ü e n kleine Werte ^ in

Schritt 3 ehe zu einem Anstieg der Koeffizienten als groß. erschieden stab ian-

ten des LU-Zerlegungsalgoithmus unterscheiden ich dahe dain, mit welchem Aufwand

nach betagsgroßen Pivot-Eementen gesucht w i . Beste S t a i t ä t bietet natürlich die

og. vollsändige PivotSuche, bei der jeweils das betragsgrößte Element der ativen Ma

rix BfsJ gewählt w i . Dessen Betimmu bedeutet ab ft einen nicht azeptablen

Rechenafwand, daß meist weniger s t e n Vaianten z Einsatz kommen. Oft wird

da betragsgrößte Element einer Spalte ode Zeil gewäht (partielle PivotSuche). Wie

im folgenden Abchnitt eschieben weden ei d n n etzten Matizen ch weni

ene Anfoderuen tell

1.7.3.2 Pivot-Auswahl für dünnbesetzte Matrizen

Während eine iminatinsschittes kann in Schitt 5 ein lemente B? +1 werden

für das Bf 0 g a t Derati Elemente heißen Fülelemente Damit auch die Faktoren L

und U d ü n n e t z t l e i e n da eachtet weden da öglicht wenig Fülemente

enttehen

Das folgende i t das Standardeispiel für den entscheidenden Einflß der Pivot-Auswah

die A n z h l vo Fillementen ä h t man bei einer Matix mit de B e e t z g s s t r u k t u r

V

als Pivot-Eement •, o entsteht nach diesem Eliminatinsschritt eine dicht setzte Matrix

Wählt man hingegen ein andere Diagonalelement, so entteht kein weiteres Fillelement

Leider ist die B e t i m m g der Folg von Pivot-ementen die zur g i n g s t e n Menge vo

Fillelementen f ü , ein P-schwer oblem [10] D e h a b urden rschiedene Heuri

tiken entwic m den F l l g i n haten.

s g b t zwei grundlegende Ansätze zur Fillminimierun Der eine steht darin, die

Matrix worder Ftorisierung so z permutieren daß anschließend die Diagonalemente als

Pivot-emente verwendet werden können und möglichst wenig Fülelemente aftreten Ein

Beispie hiefür sind s Skyline Slve bei denen eine Permtation de Zeilen und Spaten

de Matrix esucht wi daß lle NNEs „nahe" an der Diagonalen liegen. Dadurch i t bei

der anschlieenden F a t o r i s i e r u g gewährleistet daß sich der Fill uf einen engen Beeich

um die Diagonale (die Skyline) beschänkt. Diee M e t h d e e i n e t sich b e n d e r s für den

symmetischen F l l , wenn zustzlich noch eine peziell Struktur de M a i x usgentzt

weden kann (etw vo F i n i t e e m e n t e G i t t e n )](https://image.slidesharecdn.com/soplex-tr-100422010730-phpapp02/85/Soplex-tr-90-320.jpg)

![17. LÖSUNG LINEARER GLEICHUNGSSYSTEME MIT DER BASISMATRIX

Der zweite Ansatz ist die lokale Fllminimierung. Dabei weden während des liminati

nsvorgan die Pivot-Elemente gewählt, daß in jedem Schitt nur ein geringer Fill z

waten is Für M a i z e n hne bekannte Strukur haben sich kale Methoden als ü n t i

ge wiesen. Seien rf nd cj die Anzahl der NNEs in der i-ten eil bzw de j-ten pate

de aktiven Matrix BaJa im s-ten Eiminationsschitt Dann ist m|- (r| )(c^ —

ween Schritt 4 eine o b r Schrank für die Anzah vo Fillelementen die ei de Wahl vo

Bf ls P i v o t e m e n t im s-ten Schitt entstehen kann Man nennt m?„ die MarkowtzZahl

de Eementes B Lokale Pivottrategien wählen als PivotElemente s c h e mit ringe

Markowitzahl. Verschiedene ianten unterscheiden sich darin, wieie Afwand für die

Suche nach ementen mit n i e d g MarkowitzZhl getieben w i d

Bei der Fillminimierug muß j e d c h auch die Stabilität der LU-Zerlegug berksichtig

werden Wie in 17.3. beschrieben müssen dafür Pivot-Elemente mit möglich großem

B e t r g gewählt werden. Es g t also, einen Kompromiss zwischen Fillminimierung (kleinste

MarkowitzZahl) und Stabilität betragsgrößtes NNE) zu schließen. In der P a x i ha ich

dafür die Schwellwertpivotsuche bewährt ür einen v o r g e n e n Schwellwe 0 < u

weden als PivotElemente ll NN r l b t , für die

> ma 11

gil ür u = 1 entspicht dies der partiellen PivotSuche K e i n e e Werte von u r l a e n

die Wahl von P i v o t e m e n t e n mit kleinere Markowitz-Zah glicherweie j e d c h

Koten der S t a b i t Als ti h a e n ich Schwellwete 01 wieen

1.7.3.3 Implementierung

In den v o e n beiden Abschnitten wurde de Rahmen für die Wah des sugsvefahren

für line Geichungssysteme im Simplex-Algoithmus bgestect. Nun oll die für So-

Plex g e w ä t e Vaiante nd deren mpementierung vorgestellt weden. Dabei git es zwei

A s p e t e z b c h e i b e n , in denen ich Unterschiede verschiedener m p l e n t i e r u e n vo

LU-Zrlegungsalgorithmen für dünnbesetzte nicht symmetrische Matizen m a n i t i e r e n

Die ist z m einen das zugrundeieende Datenlayout zur Speicherung der dünnbesetzten

Marizen und zum anderen die S t r t e i e bei der Suche nach ü t i e n P i v o t e m e n t e n

im inne der Schwellwetpivotsuche

E gib eine Reihe unterschiedicher Speicherschemata für n n e t z e Matrizen

39, 89]. D a e i nterscheidet man zwichen der Speicheru der NN in Feldern nd ihrer

peicherung in verketteten Listen Von der Komplexitätabschätzng her sind für LU-

Zerlegugsalgoithmen, bei der F l i e m e n t e entstehen nd ander Eemente Null weden

können, doppe verkettete Liten b o n d e r s geeinet [89]. Auf heutien Cachechitekt

en t e t e n ab ei einem L i t e n a n t z häufig s CacheMisss 9 f da kein gul

Ein Cache-Miss führt dazu, daß der Prozessor seine Arbeit einige Taktzyklen unterbrechen muß

bis die geforderten Daten vom Hauptseicher nachgeladen w r d e n . D a d r c h verlangsamt sich di

earbeitngsgeschwindigkeit](https://image.slidesharecdn.com/soplex-tr-100422010730-phpapp02/85/Soplex-tr-91-320.jpg)

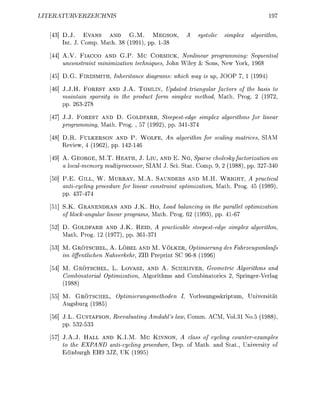

![KATEL 1. REIERTE MPLEALGITHME

HstartDL] HStartEj]

Feld

num[i]

max[i]

Abbildung 1.8: Speicherlayout für di NNEs der Zeilen der Arbeitsmatrix beim LU

Zerlegungsalgorithmus von SoPlex: Alle NNEs aller Zeilen werden in einem gemeinsamen NNE-Feld

gehalten. ür die ite Zeile wird jeweils ein Zeiger s t a r t [ i ] a f das erste NNE in dem Feld sowi di

Anzahl num[i] der NNEs der i-ten Zeile geseichert chließlich wird di Anzahl der NNE i Feld bi

r nächsten Zeil in max [ i ] verwaltet

peicheug lg

D e h a b urde für SoPlex einer Speicherung in Feldern der Vrzug ggeben, ähnich de

in 92] bschriebenen. Die A e i t m a t i x w i d zeienweise a b p e i c h e r t : Die NN all

Zeilen weden in einem Fel ltet. Für Zeile i w i d in s t a r t [i] ein Zeiger da

erste NN in dieem in num [i] die Anzahl der NNE des Zeilenektrs und in max [i]

die Anza de im f ü g b e n NNESpeichelätze i ur ächten Zeil peiche

(gl Abbd 8

s weden als nicht nur die NNEs sndern auch die cher dazwischen vewaltet: Die

D i r e n z max [i] - num [i] b c h r e i b t unbenutzten NNE-Speicher, in dem Fillemente für

die te eile erzeugt weden können. Entstehen hingeen Fllelemente wenn max[i] ==

num[i] w i d die betffene Zeile an da Ende de benutzten Teils des NNEFldes

kopiert w ch genügend peicherplatz für die Fill-Elemente breitsteht (andernfalls

w i d das Fed rgrößrt). Dabei wird der von de verschobenen Zeile z v o b e a n r u c h t e

Platz de davor efindichen Zeile als freier N N E p e i c h e hinzugefügt. Um dies effizient

durchfüren zu können, werden all eien in eine d p p e l rketteten L i t e watet die

nach de Anfangsaddsse im NN tiet i

chließlich weden die Indizes de Matrix-NNEs auch paltenweise a e s p e i c h e t , wobei

dasselbe L a y o t benutzt w i d Dies glicht a c h einen patenweien u g r f minde

die Indize der NNE de M a i x

Das zweite Unterscheidungskriterium für vrschiedene L U - F i e r u g s l g o r i t h m e n

ist die Pivot-Ausah A c h hie ientiert sich SoPlex an der in 92] chriebenen Stra

t e i e , die wiederu gerinfügi geändet wurde. E werden d p p e l t verkettete Listen

Zi und St für i = l . . n g e r t . Jede Zeilenindex i und Spaltenindex j der aktiven

T e i m a i x wird in der Liste Zr bzw Sc* verwaltet. Wenn ich die Anzahlen der NNEs r

oder ei einem PivotSchitt ände weden die Indize bzw j in die e n t e c h e n d e n

Liten rschoben](https://image.slidesharecdn.com/soplex-tr-100422010730-phpapp02/85/Soplex-tr-92-320.jpg)

![17. LÖSUNG LINEARER GLEICHUNGSSYSTEME MIT DER BASISMATRIX

Die Liten ermglichen einen schnellen Zugrf a f Zeien bzw Spaten mit enau i

N N E . Insbesonde kann schnell von kleinen W t e n auwä die Zeile oder Spalte mit

der g i n g s t e n Anzahl von NNEs sucht weden Aus einigen (1-4) in diesem Sinne ersten

Zeilen oder Spalten w i d dasjenie NNE als Pivot-Element ausgewählt da die ingste

Markowitzzahl fwei nd die chwellwebedingu füllt

Zur Ü e r p f u n g der Schwellwertbedingung mu de größte Bet in eine Zeie be

timmt weden Um dies nicht für jedes untersuchte NNE r n e t zu bestimmen wird ein

eld axabs v e l t e t . Ein Wert axabs [i] 0 zeigt an daß der größte Bet in der

ten Zeile nicht bekannt is mmer wenn e b e c h n e t wird, w i d e in axab [i] einge

tragen. Ändert sich abe etwas an der i t e n Z e i , so w i d wiede axab [i] = -1 g e t z t

Dadurch w i d das Maximum imme ur dann timmt wenn e e n ö t i t w i d vo

ch nicht echnet wurde

Eine weitere wesentiche Eienschaft de Implementierung für S o e x ist, da sie gleich-

zeiti ein Maß für die Stabilitt de LU-Zerlegung bestimmt. Daz w i d da Maximum

m a x j l ß l } mitgrechnet nd auch ei den im folgenden Abchnitt z beschreibenden Up-

date der LU-Zerlegung ktulisiert. Falls nach efolgter Fktoriierung keine hinreichende

S t a i l i t t erreicht wurde wi die LU-erlegun mit erhöhtem Parameter u w i e d e h l t

Dies wird so lange iterier, bis entweder eine stabil Zrlegung g f n d e n der mit u —

eine patielle PivotSuche wendet wurde Letzte itt in de P x i nur sehr s t e n

ein

1.7.4 Lösng v n G l e i c h n g e m e m t D r a t r i z

Wie im vorigen Abchnitt schieben müssen zur ösu von linearen Gleichungssystemen

ei gegebener L U - r l e g u de Matix B LU Gleichngssysteme mit den p e t i e t e n

Dreiecksmatizen nd t weden ür eichgssysteme der F ( ind

die

11

nd H

wofür nun die zugehören Algorithmen die Vowä und Rückwärtssubstitti da

tellt werden Die entsprechenden Algrithmen für Geichngssysteme der F r (110

t man einfach durch T a n i t i nd weden d e h a nicht nähe b c h i e e n

Betachte zunächst die L s u n des System (1.116) wobei L eine untere Deiecksmatrix

mit D i a n a l e m e n t e n 1 sei. Der L ö s u g s l g r i t h m u s arbeiten in n Schitten wobei n die

Dimensio von L Ausgehend von y wid in jedem chritt a k t s i e , wobei

jeweils ein weite Eement de Lösungsveors von (1.116) beechnet wird. Dabei wir

ausgenutzt, da ween de D e i e c k s g t a vo jeweils eine eile mit nur ch eine

Unkannten](https://image.slidesharecdn.com/soplex-tr-100422010730-phpapp02/85/Soplex-tr-93-320.jpg)

![1.7. LÖSUNG LINEARER GEICHUNGSSYSTEME MIT DER BASISMATRIX

1.7.5 Bas-Up

n jeder Iteration Simplex-Algorithmen sin zwei linare Gleichungssysteme mit der

Basismatri zu lösen, wobei sich diese von Iteration zu Iteration ändert. Jedesmal ei neue

LU-Zerlegung zu berechnen wäre zu aufwendi, zumal sich die Basismatri nur in einer

Zeile oder Spalte genüber der aus der vrigen Itertion unterscheidet und es geeignete

Verfahre gibt, um die alte LU-Zerle weiter zu verwenden. Zwei slcher sog. LU

Uates nämlich die duktform F) [29] nd der ForestTomlin Update [46] in der

Implemetierung nach [93], werden in diesem Abschnitt am Beisiel des in der iteratur

üblicheren Falles e i e s Spaltentausches beschriebe. Beide wurden für SoPlex implemen-

tiert, d s zweite ween seier besonderen Effiziez [46] nd PF wegen seiner Anwendun

beim parallelen Simple l. Abschitt 2.2.3) Nicht imlementiert wurde das Verfahre

von Bartels und G l u b 10 mit sei Weiterentwicklu [84, 86] oder sezielle Upd

teverfhre für V r c u t e r

Betrachte die Matri B, zu der die LU-Zerlegng B LU bekannt sei ie Matrix

B' BV, mit V (I + (B~1r — efief eht aus B durch ustausch der /-ten palte mit

dem Vektor hervr. Das Ziel ist es, ei Verfhre zu fnden, mit dem G l e i c h u s s s t e m e

mit B' unter V e r w e d u g der LU-Zerle e l s t werde könn

Das u r s p r ü l i c h e Verfahren, d s für SimplexAgorithmen verwendet wurde, basiert

auf (der t r a n s p i e r t e n Version v n ) Gleichung (18 Damit kann man Gleichungssysteme

der F r m B = b lösen, i d e m an zuächst Bx b mit der bekannten LU-Zerle

st u anschließed

- e (111

bestimmt. Dabei wird der V e k t r B r ohehin als A / im Simplex-Agorithmus berechnet

Bei mehreren U p d t e s müsse ntspreched iele Krrekturschritte nach (1118 durch

eführt werde

hrend das obige Verfhren die LU-Zerlegun von B aufrechterhält, wird diese durch

da nun zu beschreibende Verfhren v F r e s t u d Tomin anipuliert. Betrchte d z u

die LU-Zerle nB i der (1112) eleitete rm

U7

wobei PU eine obere Dreiecksmatrix ist Da ft iele Spalten von L mit der Eiheitsma-

trix ü b e r e i s t i m m e , s i d meist w e i e r ls ang1-Matrize Lj öti

Betrchte L V.

+iB-ef

U B U .

U.](https://image.slidesharecdn.com/soplex-tr-100422010730-phpapp02/85/Soplex-tr-95-320.jpg)

![KAPITE 1. REVIERTE SIMPEXRITHMEN

1. Tips und Tricks

Nachdem de o r i g n Abschnitten die r u d l a g e n für eine numerisch stabile Imple