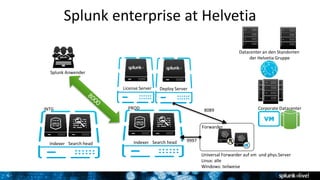

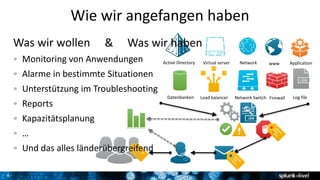

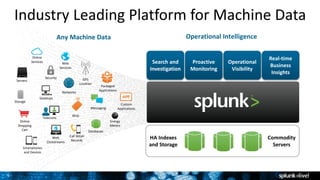

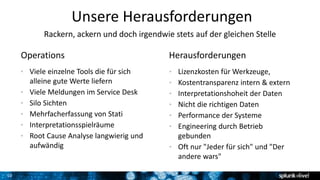

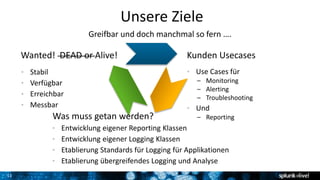

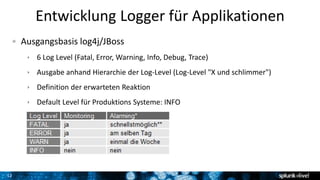

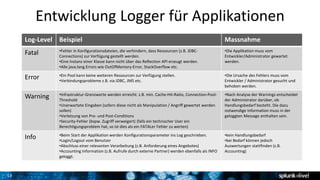

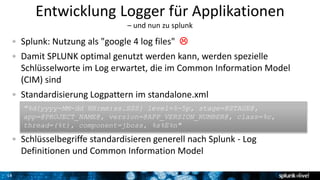

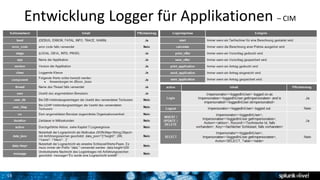

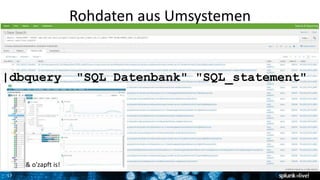

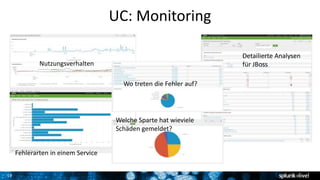

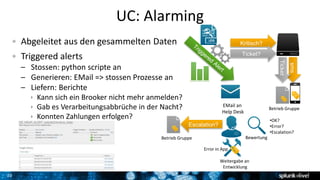

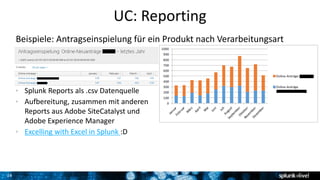

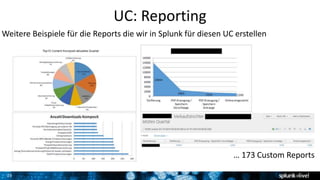

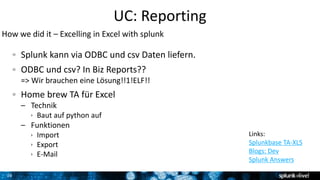

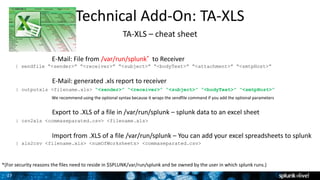

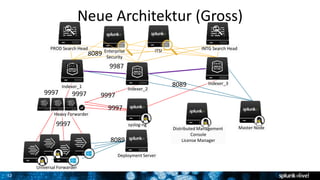

Das Dokument beschreibt die Implementierung und Nutzung von Splunk bei Helvetia für das Monitoring, die Analyse und das Reporting maschineller Daten. Es werden aktuelle Herausforderungen, Ziele und spezifische Anwendungsfälle (Use Cases) behandelt, um die Effizienz und Verfügbarkeit von Kundenanwendungen zu verbessern. Zudem wird auf die Notwendigkeit der Etablierung von Standards für Logging und das Reporting hingewiesen, um die Qualität der gesammelten Daten zu erhöhen.