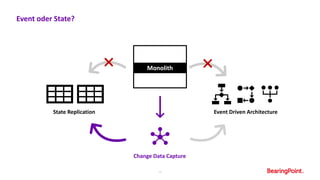

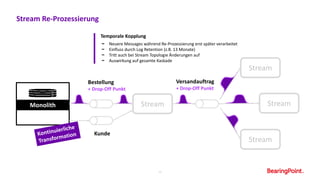

Das Dokument beschreibt den Transformationsprozess eines Unternehmens weg von einem monolithischen System hin zu einer entkoppelten Architektur unter Verwendung von Event Streaming und Apache Kafka. Es werden die Ansätze und Methoden erläutert, die zur Verbesserung der Bereitstellungsgeschwindigkeit neuer Features und zur Erhöhung der Verfügbarkeit von Funktionen verwendet wurden. Zudem werden Herausforderungen und Lösungen im Umgang mit Datenströmen und Systemintegrationen behandelt.