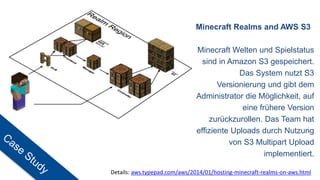

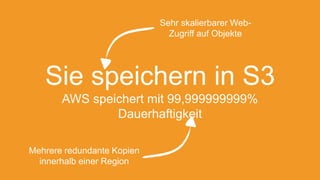

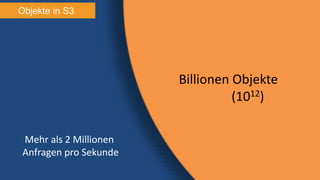

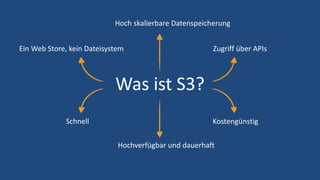

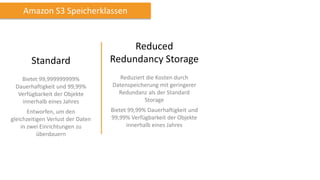

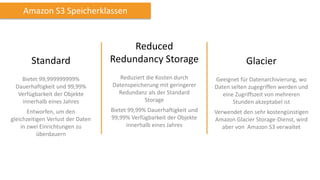

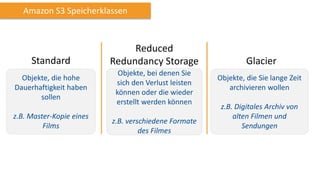

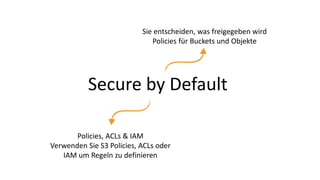

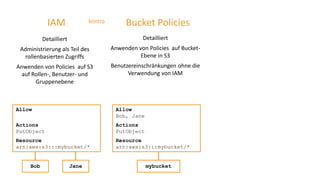

Amazon S3 ist ein hoch skalierbarer, zuverlässiger Speicher-Service, der eine Datenhaltbarkeit von 99,999999999% bietet und für verschiedene Anwendungen, wie z.B. die Speicherung von Minecraft-Welten, genutzt wird. Nutzer können S3 für unterschiedliche Anforderungen, einschließlich Archivierung und Zugriffskontrolle, verwenden, wobei auch verschiedene Speicherklassen zur Verfügung stehen, die auf spezifische Anforderungen abgestimmt sind. Die Automatisierung von Lebenszyklusmanagement und Sicherheitsrichtlinien ermöglicht eine effiziente Datenverwaltung in der Cloud.

![{"Statement":[{

"Effect":"Allow",

"Principal":{"AWS":["4649-6425", "5243-0045"]},

"Action":"*",

"Resource":"/mybucket/*",

"Condition":{

"IpAddress":{"AWS:SourceIp":"176.13.0.0/12"}

}}]}

Zugriffskontrolle – Bucket Policy](https://image.slidesharecdn.com/s3furfortgeschrittene-140813100126-phpapp01/85/Webinar-S3-fur-Fortgeschrittene-54-320.jpg)

![{"Statement":[{

"Effect":"Allow",

"Principal":{"AWS":["4649-6425", "5243-0045"]},

"Action":"*",

"Resource":"/mybucket/*",

"Condition":{

"IpAddress":{"AWS:SourceIp":"176.13.0.0/12"}

}}]}

Zugriffskontrolle – Bucket Policy

Zugelassene Accounts](https://image.slidesharecdn.com/s3furfortgeschrittene-140813100126-phpapp01/85/Webinar-S3-fur-Fortgeschrittene-55-320.jpg)

![{"Statement":[{

"Effect":"Allow",

"Principal":{"AWS":["4649-6425", "5243-0045"]},

"Action":"*",

"Resource":"/mybucket/*",

"Condition":{

"IpAddress":{"AWS:SourceIp":"176.13.0.0/12"}

}}]}

Zugriffskontrolle – Bucket Policy

Ressource](https://image.slidesharecdn.com/s3furfortgeschrittene-140813100126-phpapp01/85/Webinar-S3-fur-Fortgeschrittene-56-320.jpg)

![{"Statement":[{

"Effect":"Allow",

"Principal":{"AWS":["4649-6425", "5243-0045"]},

"Action":"*",

"Resource":"/mybucket/*",

"Condition":{

"IpAddress":{"AWS:SourceIp":"176.13.0.0/12"}

}}]}

Zugriffskontrolle – Bucket Policy

Zugelassene Quelladresse](https://image.slidesharecdn.com/s3furfortgeschrittene-140813100126-phpapp01/85/Webinar-S3-fur-Fortgeschrittene-57-320.jpg)

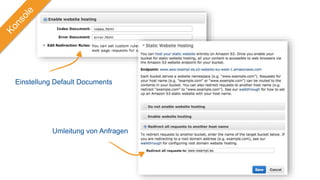

![{

"Version":"2008-10-17",

"Statement":[{

"Sid":"PublicReadGetObject",

"Effect":"Allow",

"Principal": {

"AWS": "*"

},

"Action":["s3:GetObject"],

"Resource":["arn:aws:s3:::example-bucket/*"

]

}

]

}](https://image.slidesharecdn.com/s3furfortgeschrittene-140813100126-phpapp01/85/Webinar-S3-fur-Fortgeschrittene-80-320.jpg)