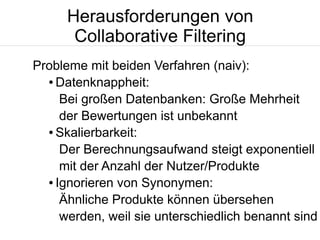

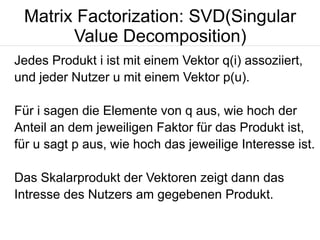

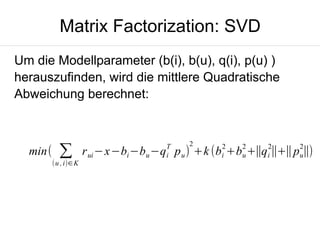

Der Vortrag von Martin Esche über Collaborative Filtering bietet eine Einführung in die Funktionsweise und verschiedene Methoden zur Verbesserung von Empfehlungssystemen, darunter Neighborhood-Modelle und Matrixfaktorierung. Es werden Herausforderungen wie Datenknappheit und die Skalierbarkeit der Modelle erörtert. Ein Vergleich der vorgestellten Modelle zeigt, dass Matrixfaktorierung, insbesondere die SVD++-Methode, bessere Genauigkeit bei der Produktempfehlung bietet und dass eine Kombination von Modellen auch vorteilhaft sein kann.