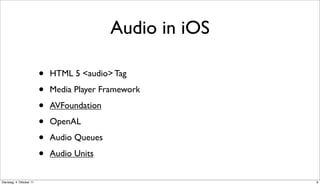

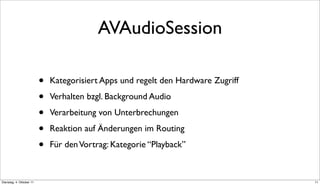

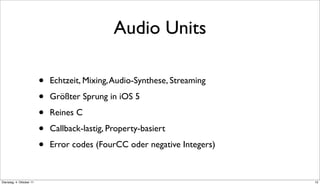

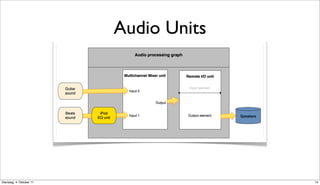

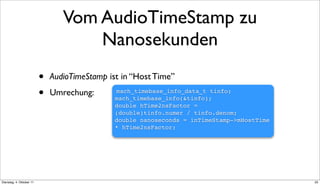

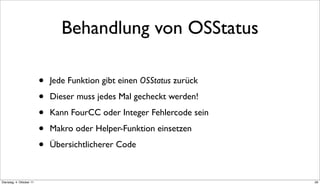

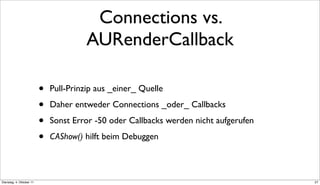

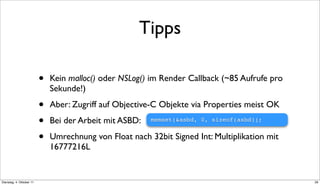

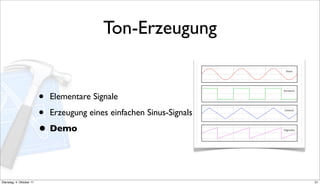

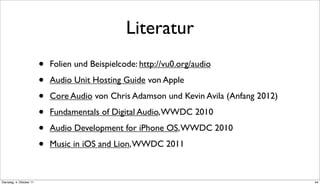

Das Dokument beschreibt eine Präsentation über Audio-Entwicklung auf iOS, einschließlich Core Audio und MIDI, die wichtige Funktionen wie das Abspielen von Samples und die Nutzung von Audio Units behandelt. Es bietet Grundlagen der digitalen Audioverarbeitung, Tipps für die Implementierung und Beispiele für effektive Nutzung der API. Neuheiten in iOS 5 und die Integration von MIDI werden ebenfalls angesprochen.